次のようなシナリオを想像してよう。電話が鳴る。従業員が電話に出ると、慌てた上司が電話越しに、「新しい契約者にお金を振り込むのを忘れてしまったので、やってほしい」と言う。電話越しの上司は振込先の情報を従業員に伝える。従業員はお金を振り込み、危機は回避された。

従業員は椅子に座り、深呼吸をして、上司がドアから入ってくるのを見る。電話の向こうの声は、上司ではなかった。人間でもない。上司の声と同じように聞こえるように、機械で作られた偽物の音声だったのだ。

このような録音音声を使った攻撃はすでに発生しており、会話音声のディープフェイクもそう遠くない将来に発生する可能性がある。

音声や映像のディープフェイクは、近年の高度な機械学習技術の発達によって初めて可能になったものだ。ディープフェイクは、デジタルメディアをめぐる新たな不確実性をもたらしている。ディープフェイクを検出するために、多くの研究者は、ビデオディープフェイクに見られるビジュアルアーティファクト(微細な不具合や不整合)の分析に着目している。

電話やラジオ、ボイスレコーダーなど、人々は映像を使わずに口頭でコミュニケーションをとることが多いため、音声による偽造はより大きな脅威となる可能性がある。このような音声のみのコミュニケーションは、攻撃者がディープフェイクを使用する可能性を大きく広げる。

私たちは、フロリダ大学の研究者とともに、音声による偽物を検出するために、人間の話し手が有機的に作成した音声サンプルとコンピュータによって合成的に作成された音声サンプルとの間の音響および流体力学的な差異を測定する技術を開発した。

有機的な声と合成された声

人間は、声帯、舌、唇など、声道のさまざまな構造物に空気を送り込むことで発声する。これらの構造を変化させることで、声道の音響特性を変化させ、200以上の異なる音、すなわち音素を作り出すことができる。しかし、人体の構造上、これらの音素の音響的挙動は基本的に制限されており、その結果、それぞれの音素の正しい音域は比較的狭くなる。

これに対し、オーディオ・ディープフェイクは、まずコンピュータにターゲットとなる話者の音声を聴かせることで作成される。使用する技術にもよるが、10秒から20秒程度の音声を聞く必要がある。この音声をもとに、被害者の声の特徴に関する重要な情報を抽出する。

攻撃者は、ディープフェイクが話すフレーズを選択し、修正したテキスト音声合成アルゴリズムを使って、被害者が選択したフレーズを話すように聞こえるオーディオサンプルを生成する。このプロセスは、数秒のうちに完了するため、攻撃者は、会話の中でディープフェイクの音声を柔軟に使用できるようになる可能性がある。

ディープフェイク音声の検出

人間が発する音声とディープフェイクによる音声を区別するための最初のステップは、声道の音響的なモデル化の方法を理解することだ。幸いなことに、科学者は声道の解剖学的な測定に基づいて、ある人物(あるいは恐竜のような生物)がどのような声を出すかを推定する技術を持っている。

私たちはその逆を行った。このような技術を逆手にとって、ある区間の音声から話者の声道形状を推定することができたのだ。これにより、音声サンプルを作成した話者の解剖学的構造を効果的に覗き見ることができるようになった。

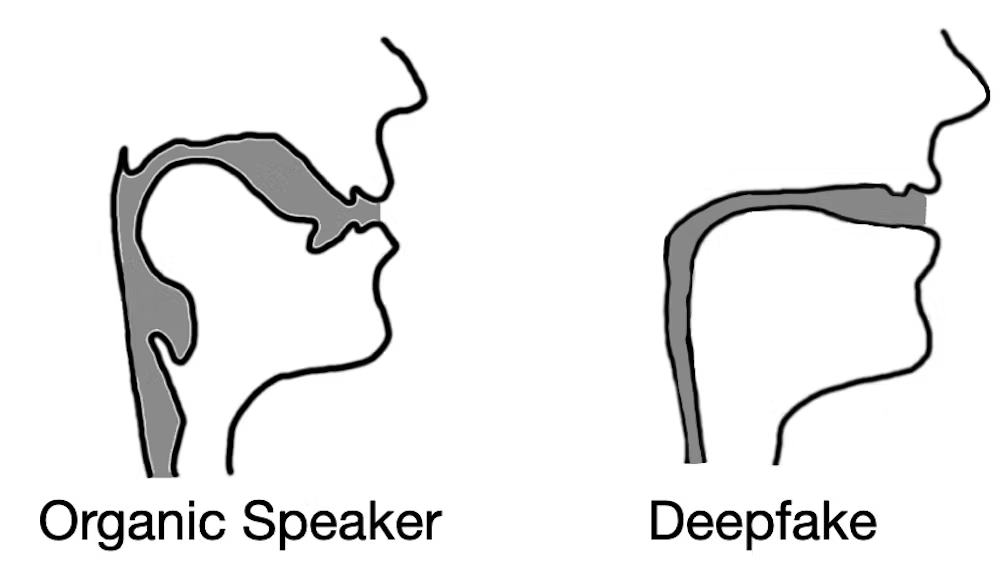

ここから、ディープフェイク音声サンプルは、人間と同じような解剖学的な制約を受けずに済むという仮説を立てた。つまり、ディープフェイク音声サンプルの解析は、人間には存在しない声道形状をシミュレートしているのだ。

検証の結果、仮説を裏付けるだけでなく、興味深いことが判明した。ディープフェイク音声から声道推定値を抽出したところ、その推定値が滑稽なほど間違っていることがわかった。例えば、人間の声道は幅が広く、形状も様々だが、ディープフェイク音声では、ストローと同じ直径と硬さの声道を推定することがよくある。

この認識は、ディープフェイク オーディオが、たとえ人間の聞き手に説得力があるとしても、人間が生成した音声と見分けがつかないというわけではないことを示している。また、音声を生成する解剖学的構造を推定することで、その音声が人によって生成されたのか、コンピュータによって生成されたのかを識別することができるのだ。

なぜ重要なのか

今日の世界は、メディアと情報のデジタル交換によって定義されている。ニュースからエンターテイメント、恋人との会話まで、あらゆることがデジタル交換によって行われるのが普通だ。ディープフェイク動画や音声は、その初期段階においてさえも、こうしたやり取りに対する人々の信頼性を損ない、その有用性を事実上制限している。

デジタル世界が人々の生活の中で重要な情報源であり続けるためには、音声サンプルのソースを特定するための効果的で安全な技術が不可欠だ。

コメントを残す