オックスフォード大学の行った最新の研究によると、ChatGPTなどの大規模言語モデル(LLM)に使用する際の言語の選択は、そのサーバー運営のコストに大きな影響を及ぼし、特に英語とそれ以外の言語との間には、タスクの実行効率において大きな隔たりがある事が明らかになった。例えば、英語の入力と出力と比較すると、簡体字中国語は約2倍、スペイン語は1.5倍、シャン語は15倍に至ってはものコストがかかることが判明した。

これは、LLMにおける入力された文章をモデルに読み込ませるために分割する「トークン化」の段階で、必要なトークンの数に差が生じている事が原因であると言う。例えば、日本語などの言語は、英語とは異なる、より複雑な構造(文法的にも文字数的にも)を持つため、トークン化の割合が高くなるからだ。

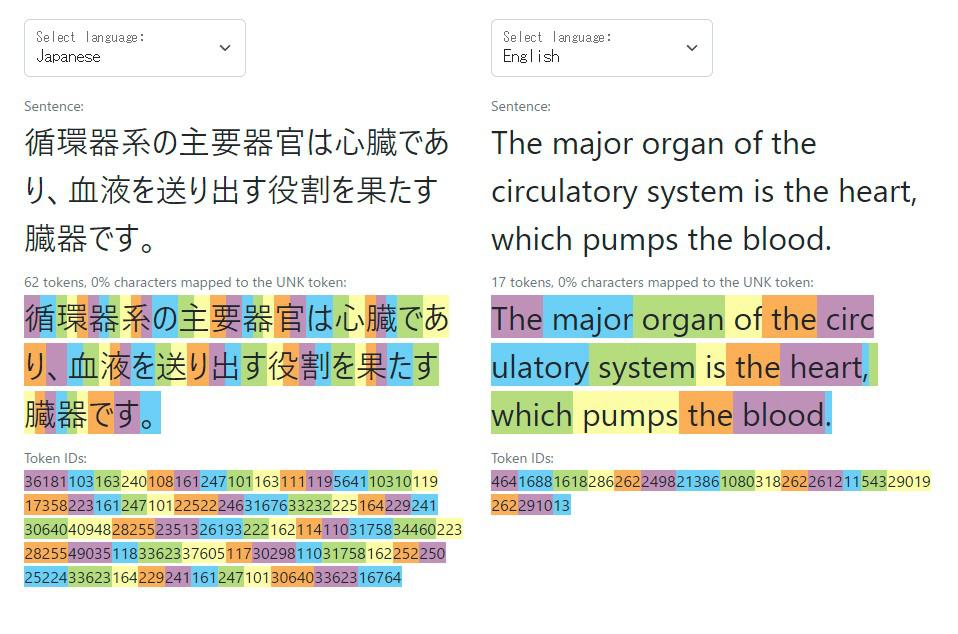

トークンはテキストデータの最小単位として機能し、文脈の捉える際やテキスト生成、テキストの変換などに利用される。OpenAIのGPT3トークナイザーを使えば、文章のトークン数が具体的にどうなるのかが視覚的に理解できるが、例えば「私のカメラ(my camera)」というトークンは、英語ではわずか2トークンだが、日本語では7トークンと3倍以上になる。Aleksandar PetrovらのTokenization Fairnessのページには、言語間の格差を見るのに使える図表やツールがたくさんある。

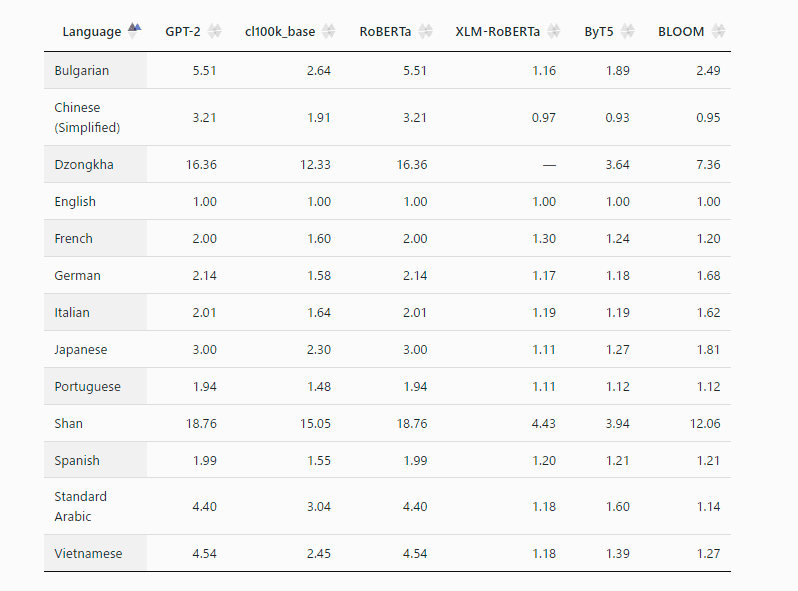

実際、LLM毎の英語を1とした場合のトークン化コストを算出した表が以下となるが、日本語は最大で3倍程度、英語よりもコストがかかることが分かる。

例えば、以下のような文章では、英語はわずか17トークンで済むところ、日本語では62トークン必要となり、効率性で圧倒的に劣ることが分かる。

この問題は、AI企業が望んでいる再帰的学習、つまりAIモデルを自らの出力で学習させる能力の実現に直結する。もしそれが達成されれば、将来的なモデルは、複雑でベースとなる学習データがより限られている他の言語と比較して、英語と同じ費用対効果を示すことになるだろう。

さらに問題を複雑にしているのは、(トークン化以外の)他の方法でコストを定量化しても、結局は同じ問題にぶつかるということだ。ビットカウントでも文字カウントでも、英語の実用的な実用性に勝てる言語はないようだ。

つまり、問題はモデルの収益化方法にあるのではなく、トレーニングのために考慮される技術や基本モデルの実際の限界なのだ。そして、この問題が複数の言語モデルのバージョンに影響を及ぼしていることは驚くことではない。結局のところ、どれもほとんど同じように作られているのだから。

この問題は、大規模言語モデル(ChatGPTなど)や生成イメージネットワーク(Midjourneyなど)を実際に導入している企業のほとんどがアメリカに拠点を置いていることを考えると、予測できることだろう。利用コストが低く、質の高いデータが入手しやすいということは、大きな違いを生む。

このコスト差もあり、すでに多くの国が母国語のLLMを育成し、配備する独自の取り組みを始めている。中国でもAlibabaやTencentなどのテック企業が取り組んでおり、日本でもこうした動きが活発だ。だがどれも英語ベースのAIネットワークが可能にする技術革新のペースに伴う計画が必要だということだ。そしてそのペースは、ほとんどの場合、アクセスやトレーニングのコストによって制限されている。

そして、こうした力学は、ベースとなる言語に応じて、LLMのトレーニングと展開のコストに直接影響する。このAIビジネスは非常に複雑で、その影響は広範囲に及ぶため、私たちは小さな一歩一歩に細心の注意を払わなければならないのだ。

論文

参考文献

- Language Model Tokenizers Introduce Unfairness Between Languages

- Research Gate: Do All Languages Cost the Same? Tokenization in the Era of Commercial Language Models

研究の要旨

最近の言語モデルは、明示的に訓練されていない場合でも、印象的な多言語性能を示している。にもかかわらず、異なる言語間での出力の品質について懸念が提起されている。本稿では、異なる言語の扱いにおける格差が、モデルが呼び出されるよりもずっと前の、トークン化の段階でどのように生じるかを示す。異なる言語に翻訳された同じテキストでも、トークン化の長さが大幅に異なることがあり、場合によっては15倍もの差が生じる。このような不一致は、今回評価した17のトークナイザーで、たとえ多言語対応のために意図的にトレーニングされたものであったとしても変わりません。文字レベルとバイトレベルのモデルでも、言語ペアによってはエンコード長に4倍以上の差がある。これは、商用言語サービスへのアクセスコスト、処理時間と待ち時間、モデルにコンテキストとして提供できるコンテンツの量に関して、一部の言語コミュニティに不公平な扱いをもたらす。そのため、将来的には、多言語で公平なトークナイザーを使って言語モデルを学習すべきである。

コメントを残す