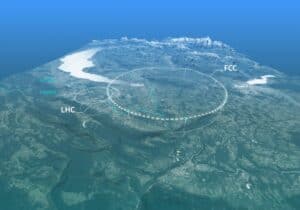

欧州原子核研究機構(CERN)は、人類がこれまでに取り組んだ中で最も野心的な工学的・科学的試みのひとつを主催している。大型ハドロン衝突型加速器(LHC)は世界最大かつ最高エネルギーの粒子加速器であり、科学者が素粒子の世界の構造の証拠を分析するために使用している。

CERNは最近、大型ハドロン衝突型加速器の新たな実験段階(LHC Run 3)に備えて、バックエンドのITシステムをアップグレードしなければならなかった。このフェーズでは、2025年末まで毎日1ペタバイトのデータが生成されると予想されている。以前のデータベースシステムは、CMSのような衝突型加速器の主要実験によって生成される「高カーディナリティ」データを扱うにはもはや十分ではなかった。

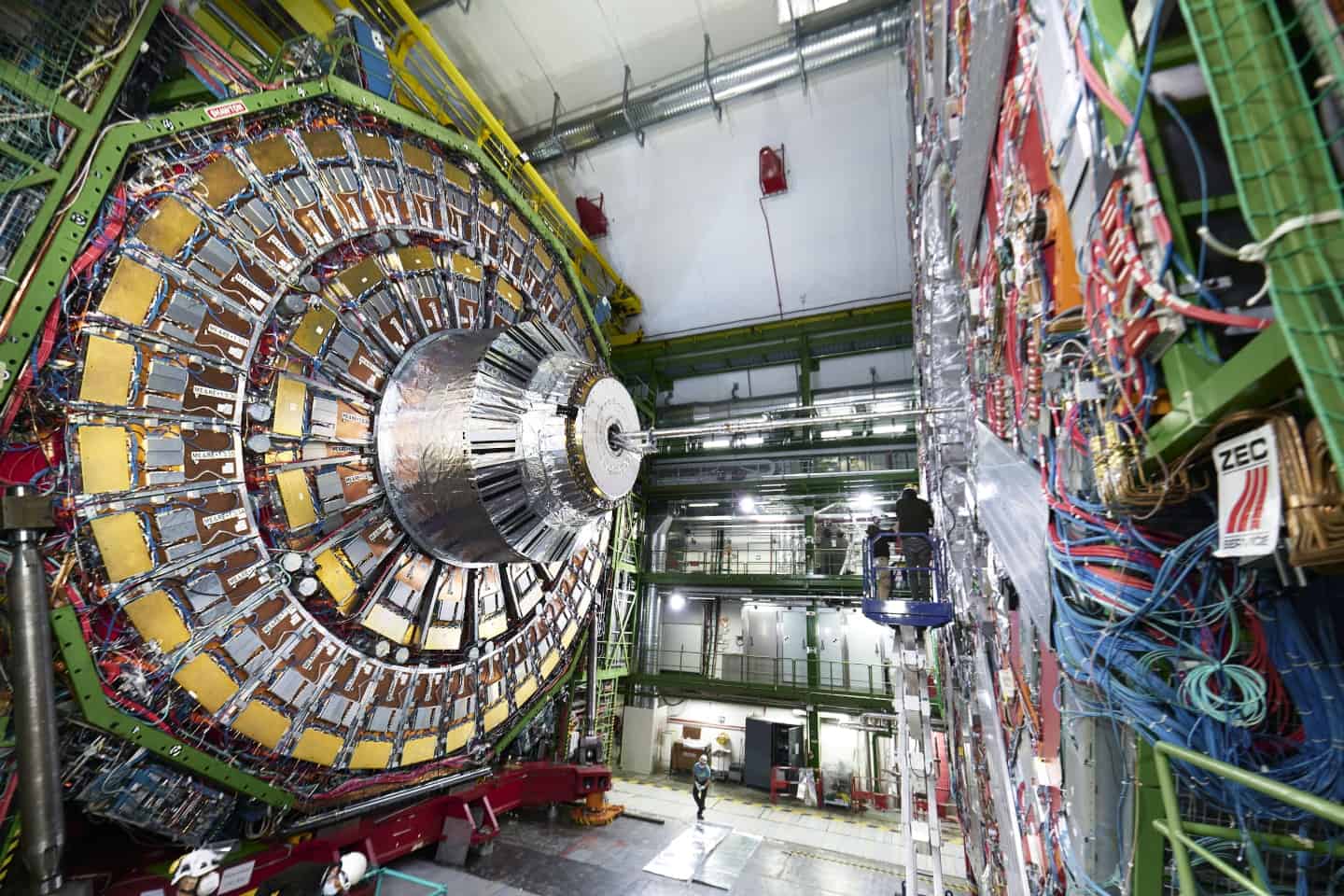

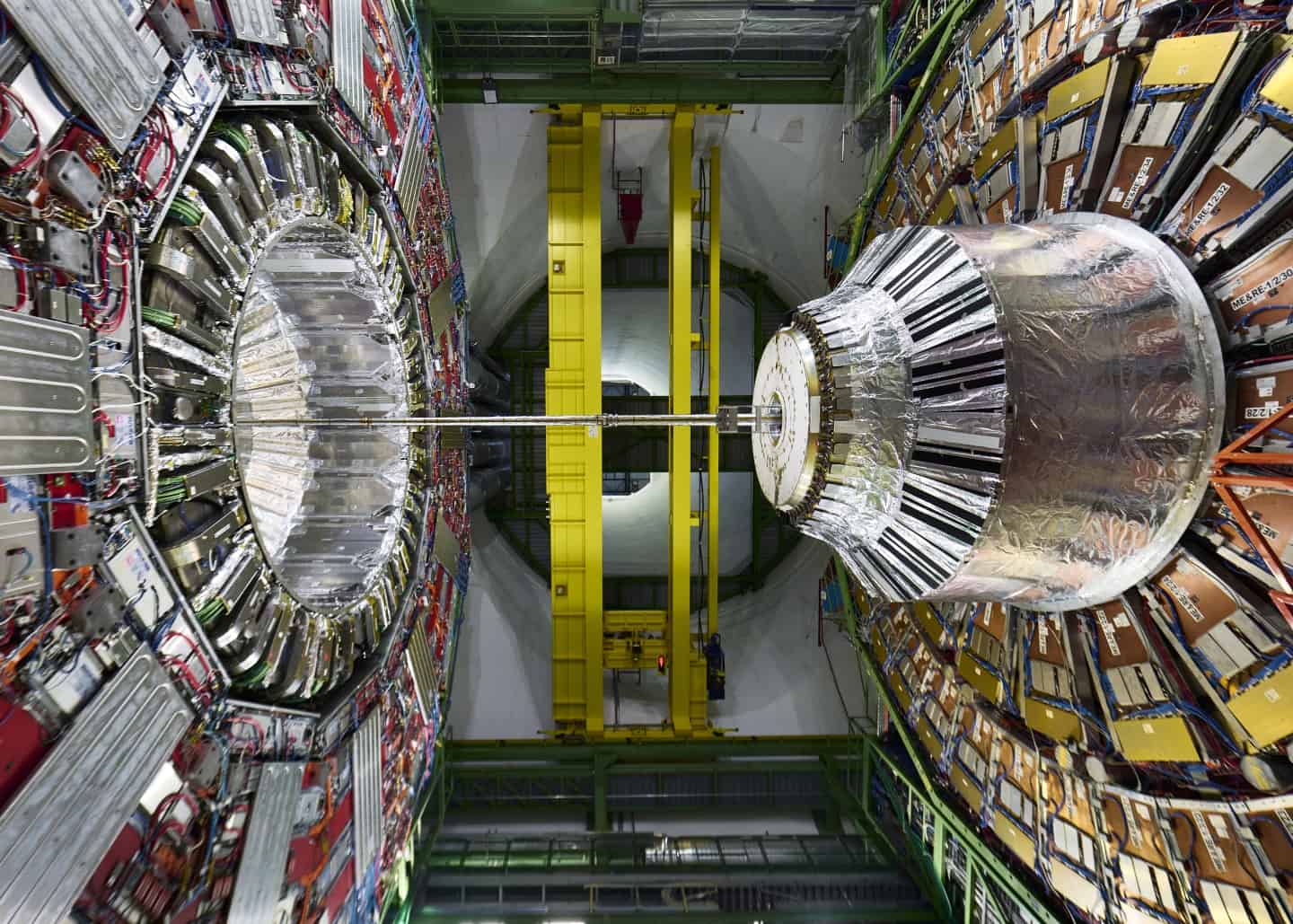

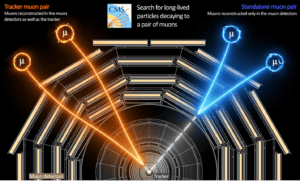

コンパクト・ミュオン・ソレノイド(CMS)はLHCの汎用検出器で、広範な物理プログラムを持つ。標準模型(ヒッグス粒子を含む)の研究と、余剰次元や暗黒物質を構成する可能性のある粒子の探索を包含している。CERNはこの実験を、54カ国の241機関から約5500人が参加する、史上最大規模の科学共同研究のひとつであると説明している。

CMSと他のLHC実験は2018年から2022年にかけて大幅なアップグレードを行い、現在は3年間の「Run 3」データ収集期間中に素粒子の衝突を再開する準備を整えている。停止期間中、CERNの専門家はCMSをサポートする検出器システムとコンピューティング・インフラの大幅なアップグレードも行った。

CMSと共同研究している科学者であるBrij Kishor Jashal氏は、彼のチームがインフラのパフォーマンスを監視するために30日間で30テラバイトのデータを集計していることを述べた。彼は、Run 3のオペレーションはより高い光度を発生させるため、データ量が大幅に増加すると説明した。以前のバックエンド監視システムは、オープンソースの時系列データベース(TSDB)であるInfluxDBに依存しており、このデータベースは、監視データベースであるPrometheusとともに、このデータを効率的に処理するために圧縮アルゴリズムを利用していた。

しかし、InfluxDBとPrometheusは、特に高カーディナリティデータを扱う際に、パフォーマンス、スケーラビリティ、信頼性の問題が発生しました。高カーディナリティとは、繰り返される値の多さと、新しいインスタンス間でアプリケーションを複数回再デプロイできることを指します。これらの課題に対処するため、CMSモニタリングチームは、InfluxDBとPrometheusの両方をVictoriaMetrics TSDBデータベースに置き換えることを選択した。

VictoriaMetricsは現在、CMSのバックエンド・ストレージとモニタリング・システムの両方を兼ねており、以前遭遇したカーディナリティの問題に効果的に対処している。Jashal氏は、CMSチームは現在、クラスタとサービスのパフォーマンスに満足していると述べた。まだスケーラビリティの余地はあるが、サービスはCMSの専用Kubernetesクラスタ内で「高可用性モード」で運用されており、信頼性の保証が強化されている。CERNのデータセンターは、堅牢なx86マシンのクラスタ上で稼働するOpenStackサービスに依存している。

Sources

コメントを残す