Amazonは本日、毎年恒例のプレスイベントを開催し、多くの新しいハードウェア・デバイスを披露した。同社はまた、このイベントにおいて、Amazon独自の生成AI機能の開発計画についても語った。

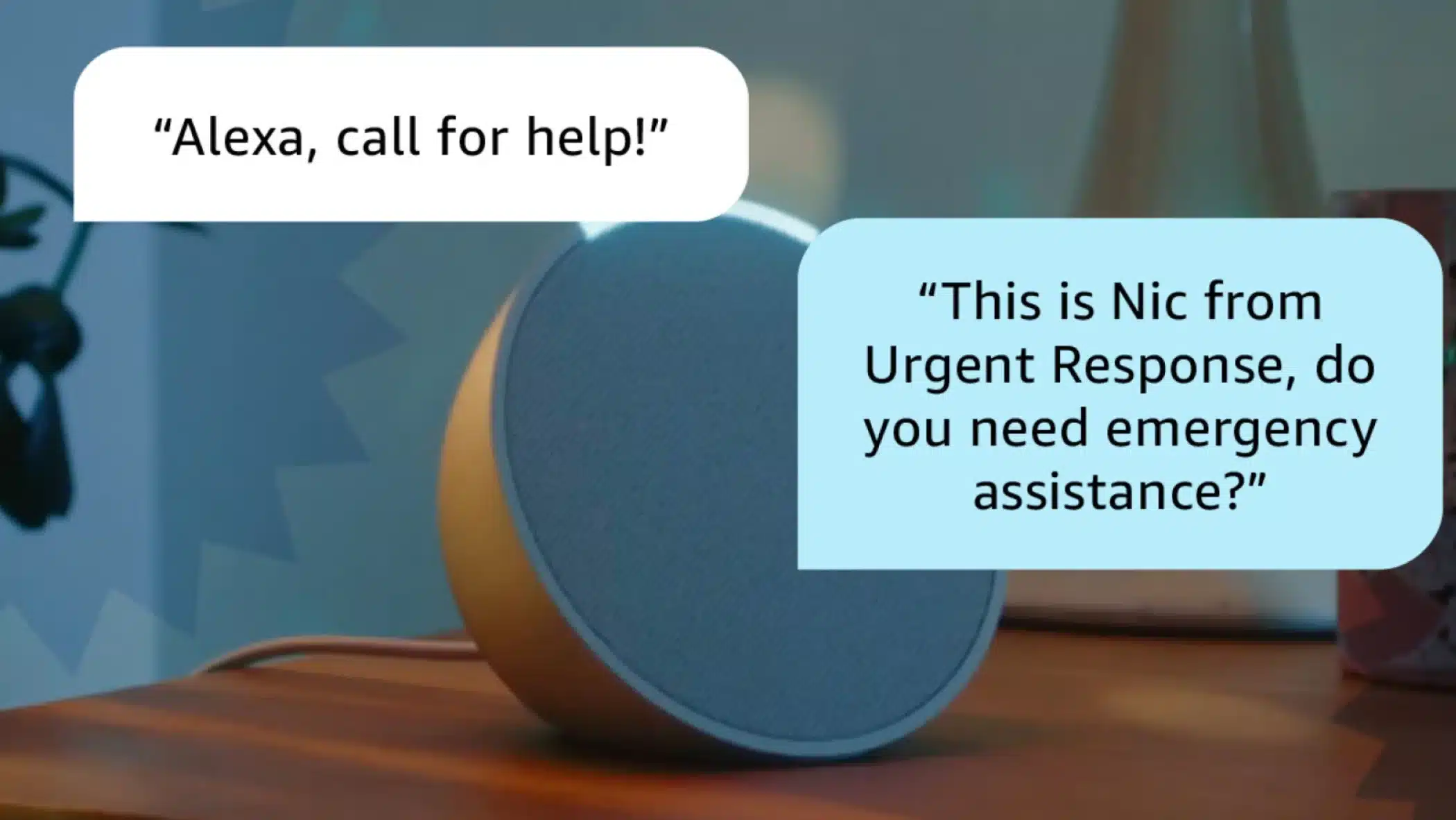

Amazonは、デジタルアシスタントAlexaと組み合わせるための新しい大規模言語モデル(LLM)を開発していることを明らかにした。この新たなAlexa LLMの導入により、「自然な会話」「直感的なスマートホームコントロール」「視線による制御」「会話翻訳」「Alexa緊急アシスト」が利用可能になる。この新たなAlexaは、まずは米国居住者向けのAmazonのすべてのEchoデバイスで、まもなくプレビュー版として利用可能になる予定だ。

Amazonは次のように述べている:

私たちの最新モデルは、リアルタイム情報へのアクセス、スマートホームの効率的なコントロール、ホームエンターテインメントの最大活用など、私たちがお客様が大好きだと知っている音声と事柄のために特別に最適化されています。

新しいAlexaが目指す物は、「人間と会話するのと同じくらい自然に対話が出来る事」という事で、実際に以下のでも動画にあるように、Amazonの新しい音声認識技術は、あなたの自然な間やためらいを調整し、より自由な会話を提供してくれる。

これを実現するのが、Amazonの新たなLLMであり、音声対話のためにカスタムビルドされ、特に最適化されているとのことだ。Amazonは以下のように説明する:

まず音声認識を使って顧客の音声要求をテキストに変換し、次にLLMを使ってテキストの応答やアクションを生成し、音声合成で音声を返すのではなく、この新しいモデルはこれらのタスクを統合し、より豊かな会話体験を生み出します。

その他、Alexa LLMにより、複数のスマートホームリクエストを同時に処理できるようになる。例えば「Alexa、ブラインドをすべて閉めて、リビング ルームの照明を除くすべての照明を消して」と言った複雑な指示や、「ここは明るすぎる」という曖昧な指示に対してもそれを理解して適切な対応をしてくれるとのことだ。

また、アクセシビリティ関連の機能も追加される。移動障害や発話障害のあるユーザーが視線によってAlexaを制御する事が出来る様な改良が行われる。これにより、音声やタッチ操作の代わりに、視線をタブレットに向けることで音楽やショーの再生、自宅環境のコントロール、大切な人とのコミュニケーションなど、あらかじめ設定されたAlexaのアクションを、手や声を使わずに実行することができるとのことだ。

加えて、Alexaの音声通話やビデオ通話をリアルタイムで翻訳する機能も搭載される。通話参加者は言語を超えたコミュニケーションをより効果的に行うことができ、加えて耳の不自由なユーザーも文字起こし機能によって遠隔コミュニケーションをこれまでよりも簡単に取ることが出来るようになるとのことだ。

この機能は、2023年後半に、米国、カナダ、メキシコ、英国、ドイツ、フランス、イタリア、スペインのEcho ShowおよびAlexaモバイルアプリのユーザー向けに、英語、スペイン語、フランス語、ドイツ語、ポルトガル語を含む10言語以上で提供されるという。

2024年、Amazonはサードパーティの開発者が新しいLLMにアクセスし、Alexaで新しい体験を創造できるようにする。そうした企業の中には、すでに新しい生成AI機能の開発に取り組んでいるところもある。Amazonはこう述べている:

私たちはBMWグループと協力して、会話型の車載音声アシスタント機能を開発しています。この機能は、車の機能に関する素早いハウツー指示や回答を含め、車と対話し、車を知るための自然な方法を提供します。

他の企業も、AlexaのAIを他のことに利用する方法に取り組んでいる。例えば、曲を作ったり、AIベースのキャラクターと自然な会話をしたりするようなことが実現するだろう。

Sources

コメントを残す