ChatGPTを動かす根幹となる大規模言語モデル(LLM)は、金融分野での使用には不適切であることが新たな研究から示唆されている。

Patronus AIの研究者たちは、OpenAIのGPT-4 TurboやClaude 2などの大規模言語モデルが、SEC(米国証券取引委員会)の報告に関する質問に答えることにしばしば失敗することを発見した。これは、金融などの規制された産業が、顧客サービスや研究プロセスにAIモデルを導入する際に直面する課題を強調している。

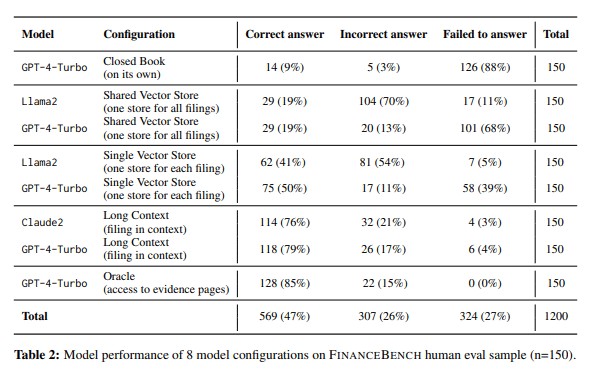

Patronus AIは、企業の財務報告に関する質問に答えるために4つの言語モデルをテストした。これには、OpenAIのGPT-4とGPT-4 Turbo、AnthropicsのClaude 2、MetasのLlama 2が含まれる。最も優れたモデルであるGPT-4 Turboでさえ、Patronus AIのテストで79%の正確さしか達成できなかった。これは、ほぼ全ての報告がプロンプトに含まれていたにもかかわらずである。

これらのモデルは、SECの報告に含まれていない事実や数字を作り出すか、質問に答えることを拒否することが多かった。Patronus AIの共同創設者であるAnand Kannappan氏によると、このパフォーマンスは受け入れがたく、自動化されたアプリケーションや製品化されたアプリケーションでの使用にはもっと高いレベルであるべきだという。

Patronus AIがテストのために開発したFinanceBenchは、主要な公開企業のSEC報告からの10,000以上の質問と回答のデータセットである。このデータセットには、正しい回答とその報告書内での正確な位置が含まれている。いくつかの回答には、単純な数学的または論理的な推論が必要である。

CVS Healthは2022年度第2四半期に普通株主への配当金を支払ったか?

AMDはFY22に顧客集中を報告したか?

Coca Colaの2021年度の売上総利益率は?損益計算書に明確に示されている項目を利用して、質問された内容を計算しなさい。

FinanceBench

研究者たちは、AIモデルが金融セクターを支援するための重要な可能性を持っていると信じているが、現在のパフォーマンスレベルは、ワークフローをサポートし管理するために人間がまだ関与する必要があることを示している。

AIシステムを特定のタスクにより慣れさせるために、プロンプトを改善することが一つの解決策かもしれない。これにより、関連情報を抽出する能力が向上する可能性がある。しかし、このようなアプローチが一般的な問題を解決するか、または特定のシナリオでのみ有効かどうかはまだ不明である。

OpenAIは、その使用ガイドラインで、資格を持った人が情報をレビューせずにOpenAIモデルを使用して個々の金融アドバイスを提供することを禁止している。

大きなコンテキストウィンドウを持つ言語モデルは、特に長いテキストの中間から情報を信頼性を持って抽出することが困難であることが知られている。この「中間での迷子」と呼ばれる現象は、LLMの大きなコンテキストウィンドウの有用性について疑問を投げかけている。

Anthropicは最近、Claude 2.1 AIモデルの「中間喪失」問題を解決する方法を開発した。これは、モデルの回答の前に「これはコンテキストの中で最も関連性の高い文です」という文を付け加えることによって行われる。この方法が多くのタスクに対して信頼性を持ってスケールし、GPT-4(Turbo)などの他のLLMに同様の改善をもたらすかどうかは、テストが必要である。

論文

参考文献

研究の要旨

FinanceBenchは、オープンブックの金融問題解答(QA)におけるLLMのパフォーマンスを評価する初めてのテストスイートである。このテストは、上場企業に関する10,231の質問と、それに対応する解答および証拠ストリングで構成されています。FinanceBenchの問題は生態学的に妥当で、多様なシナリオをカバーしています。これらは、最低限のパフォーマンス基準として機能するよう、明確でわかりやすい回答を意図しています。我々は、FinanceBenchの150のケースのサンプルについて、16の最新のモデル構成(GPT-4-Turbo、Llama2、Claude2を含み、ベクトルストアと長いコンテクストプロンプトを持つ)をテストし、その回答を手作業でレビューする(n=2,400)。ケースはオープンソースで利用可能である。我々は、既存のLLMが金融QAには明らかに限界があることを示す。特に、検索システムと共に使用されたGPT-4-Turboは、81%の質問に対して不正解または回答を拒否した。関連する証拠を入力するために長いコンテキストウィンドウを使用するような補強技術はパフォーマンスを向上させるが、待ち時間が増加するため企業環境では非現実的であり、より大きな金融文書をサポートすることはできない。我々は、検討したすべてのモデルが、幻覚などの弱点を示し、企業での使用に適していないことを発見した。

コメントを残す