Googleは本日、Google I/Oの開幕にあたり、人工知能(AI)における数々の進歩について1時間以上にわたって講演を行った。 同社は、チャットボットツール「Bard」を支える、生成AI用の新しいPaLM 2大規模言語モデル(LLM)を公開し、これらが、Google Maps、Google Photos、Gmailなど、多くのGoogleの製品ポートフォリオ全体にAIを取り入れた機能を追加するための基礎的な柱となる事を明らかにした。

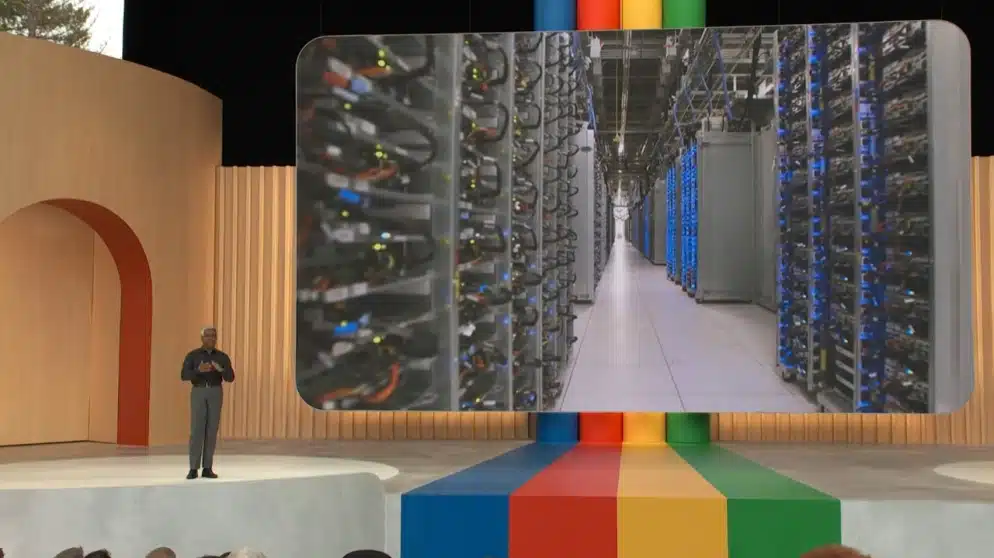

何百万人もの(そして最終的には何十億人もの)ユーザーが、写真の背景に写っている人物を削除するようなありふれた操作から、短いテキストのプロンプトに基づいてメール全体を作成するような操作まで、要求を送信するため、野生のモデルを動かすためにクラウドに大きな馬力が必要だ。そこで注目されるのが、Googleの新しいGPUスーパーコンピュータ「A3」だ。Googleは、新しいA3スーパーコンピューターが、26エクサフロップスのAI性能を実現しながら、「今日の生成AIと大規模言語モデルのイノベーションを支える最も要求の厳しいAIモデルを訓練し提供することを目的として構築されている」と述べている。

Google Cloudの顧客は間もなく、AIモデルを訓練するためのA3仮想マシンをレンタルできるようになる。GoogleのA3システムは、現在、AI駆動用のGPUとして最高の性能を持つNVIDIA H100 Hopper GPUを8つ、第4世代Intel Xeon Scalableプロセッサー、2TBのDDR5-4800 RAMが組み合わされる予定だ。GPUは、NVSwitchとNVLink 4.0を使用して、カード間で3.6TB/秒の双方向帯域幅を実現する。GPU間で直接データを移動し、CPUをバイパスすることで、A3仮想マシンは、旧来のA2仮想マシンの10倍の帯域幅を持つことになる。

Googleによると、このすべてが26エクサフロップスの処理能力になるという。だが、2022年に史上初のエクサスケール・スーパーコンピューターが登場したばかりなので、現在の最も強力なスーパーコンピューターよりも一桁高い性能を誇ることは、にわかには信じがたいが、この測定値には他のニュアンスが含まれている可能性もありそうだ。いずれにせよ、A3は、今日の最も激しい機械学習ワークロードに最適化されている。Google CloudのA3は個人向けではなく、企業向けの価格設定になる。それは、A3を構築するためのGPUハードウェアの購入が非常に高価であるだけではなく、これを駆動させるための膨大な消費電力を考慮するとコストはさらに上昇するからだが、Googleは、A3は他のどの製品よりも80%速く、50%安いと述べている。

AIトレーニングにA3 VMを使用することに関心のある企業は、プレビュープログラムへの早期アクセスに申し込むことが出来る。しかし、Googleは希望者全員が参加出来ない場合があるともしている。この種のクラウド・コンピューティング・サービスに対する需要は今、非常に高まっており、その熱が冷めない限りはこの状態が続くだろう。だが、Googleをはじめ、多くの企業が生成AIに全面的に取り組んでいることを考えると、しばらくこの状況は続くだろう。

Sources

コメントを残す