Metaは、テキスト、音声、視覚データ、温度、動きの読み取りなど、複数のデータストリームを連携させる新しいオープンソースのAIモデル「ImageBind」を発表した。

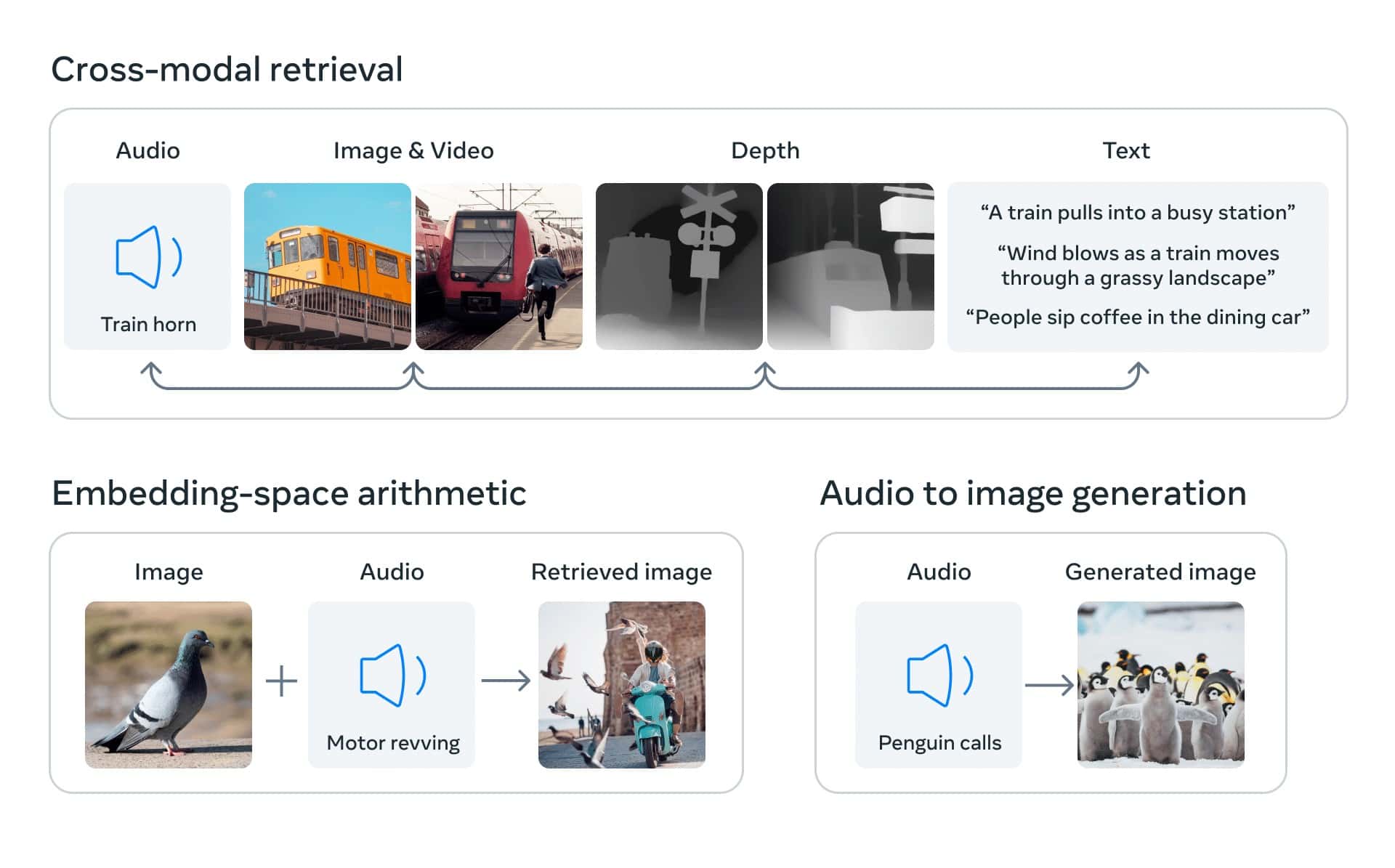

ImageBindは、テキスト、オーディオ、ビジュアル(画像と動画)、深度情報、熱(赤外線画像)、モーション(慣性計測装置(IMU)が生成する動作測定値)を含む6つの異なるタイプのデータを扱うように設計されたマルチモーダルAIである。ImageBindは、サポートされているデータモードの1つで入力を受け、他のデータと関連付けることが出来る。Metaによると、6種類のデータを1つの埋め込み空間に統合したのは、このImageBindが初めてとのことだ。

この研究の核となるコンセプトは、複数の種類のデータを一つの多次元インデックス(AI用語でいうところの「埋め込み空間」)に結びつけることだ。

例えば、ビーチの写真を入力として与えると、関連するデータとして波の音を見つけることが出来る。また、虎の写真と滝の音を与えると、その両方を組み合わせた動画を提供することができるといった具合だ。

将来のAIシステムは、現在のAIシステムがテキスト入力に対して行うのと同じように、このデータを相互参照することができるようになるということだ。例えば、音声や映像の入力だけでなく、物理的なステージ上の環境や動きも生成する未来のバーチャルリアリティ装置において、「長い船旅を再現してください」と頼むと、波の音だけでなく、足元の甲板の揺れや海風の涼しさも含めて、船の中にいるような感覚を味わうことが出来る様になるだろう。実際のデモページはこちらで確認出来る。

Meta CEOのMark Zuckerberg氏はInstagramにおいて、「これは、私たちのように周囲の世界をより理解するAIへの一歩であり、それによってAIはより便利になり、全く新しいモノづくりの方法が開かれるでしょう」と語っている。

(Credit: Meta)

Metaはブログ記事で、ImageBindが、人間が複数の感覚から情報を集め、そのすべてを同時に総合的に処理する方法に似たアプローチをとっていると説明している。将来的には、対応するデータモードを、触覚、音声、嗅覚、脳のfMRI信号など、他の感覚にも拡大する計画で、より豊かな人間中心のAIモデルを実現するとの事だ。

参考までに、「DALL-E」「Stable Diffusion」「Midjourney」などのAI画像生成システムは、学習段階でテキストと画像をリンクさせるシステムを採用している。視覚データのパターンを探し、その情報を画像の説明と結びつけるのだ。そうすることで、ユーザーのテキスト入力に沿った画像を生成することができるようになる。映像や音声を生成するAIツールも同様だ。

このモデルは、現時点では研究プロジェクトに過ぎず、すぐに消費者や実用化されるものではないが、没入型の多感覚体験を生み出すことのできる生成AIシステムの未来を提示する物で、OpenAIやGoogleなどのライバルが秘密主義を強める中、MetaがAI研究の共有を続けていることを示している。

論文

- Meta: IMAGEBIND:OneEmbeddingSpaceToBindThemAll (PDF)

参考文献

コメントを残す