スタンフォード大学の研究者は、新しい論文の中で、AIモデルにおけるいわゆる「創発的能力(Emergent Properties)」(表向きは設計されていない能力を大規模言語モデルが発揮すること)が、実は研究者によって生み出された「幻想」であることを示したと発表した。

GoogleのCEOであるSundar Pichai氏をはじめとする多くの研究者や業界のリーダーたちは、GPT-4やGoogleのBardのような大規模言語モデルは、開発者が想像もしていなかったような機能を発揮するという考えを喧伝してきた。例えばGoogleの幹部は、Bardは訓練されていないにもかかわらず、ベンガル語を翻訳することができたと主張している。Microsoftの研究者も、OpenAIのGPT-4が “人工的な一般知能の火花”を見せていると主張し、このAIは “斬新で難しいタスクを…特別な促しを必要とせずに解決できる “と言っている。このような懸念は、企業が利益を得ようとするAIモデルを誇張するだけでなく、突然人間の知能を凌駕するAIを制御できなくなることへの恐怖をかき立てた。

だが、今回、スタンフォード大学の研究者は、これらの能力は、メトリックによって引き起こされた幻想に過ぎない可能性があることを示唆した。

一般に、創発的能力とは、特定のサイズ以上のモデルで突然発現し、より小さなモデルには存在しないものを指す。このような瞬間的で予測不可能な飛躍の出現は、これらの能力の起源と、さらに重要なのはその予測可能性についての研究に大きな拍車をかけている。というのも、AI研究の領域では、予期せぬAI能力の出現は、高度にスケールされたAIネットワークが、何の前触れもなく、予期せぬ、あるいは危険な能力を身につける可能性があるという警告的指標であると考えられているからだ。

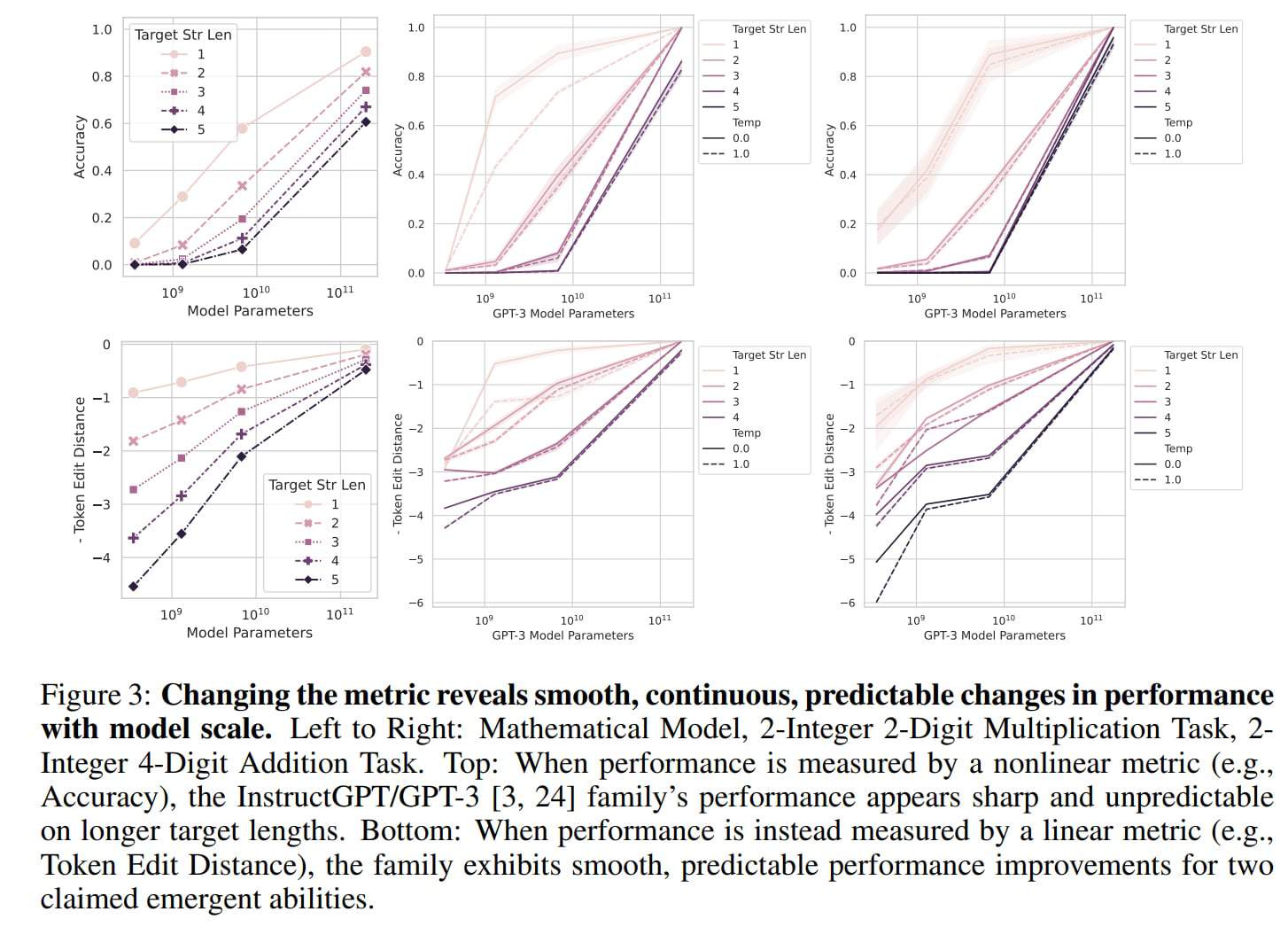

今回、スタンフォード大学の研究者らによると、GPT-3のようなモデルは初歩的な数学的能力を発達させるが、測定方法を変えると、それは創発的能力でなくなってしまうとのことだ。

創発的な能力は、特定のメトリックの結果である

「我々は、LLMが創発的な能力を持つという主張を疑問視している。具体的には、特定のタスクにおけるモデル規模の関数として、モデル出力が急激かつ予測不可能に変化することを意味している」と、研究者らは述べている。

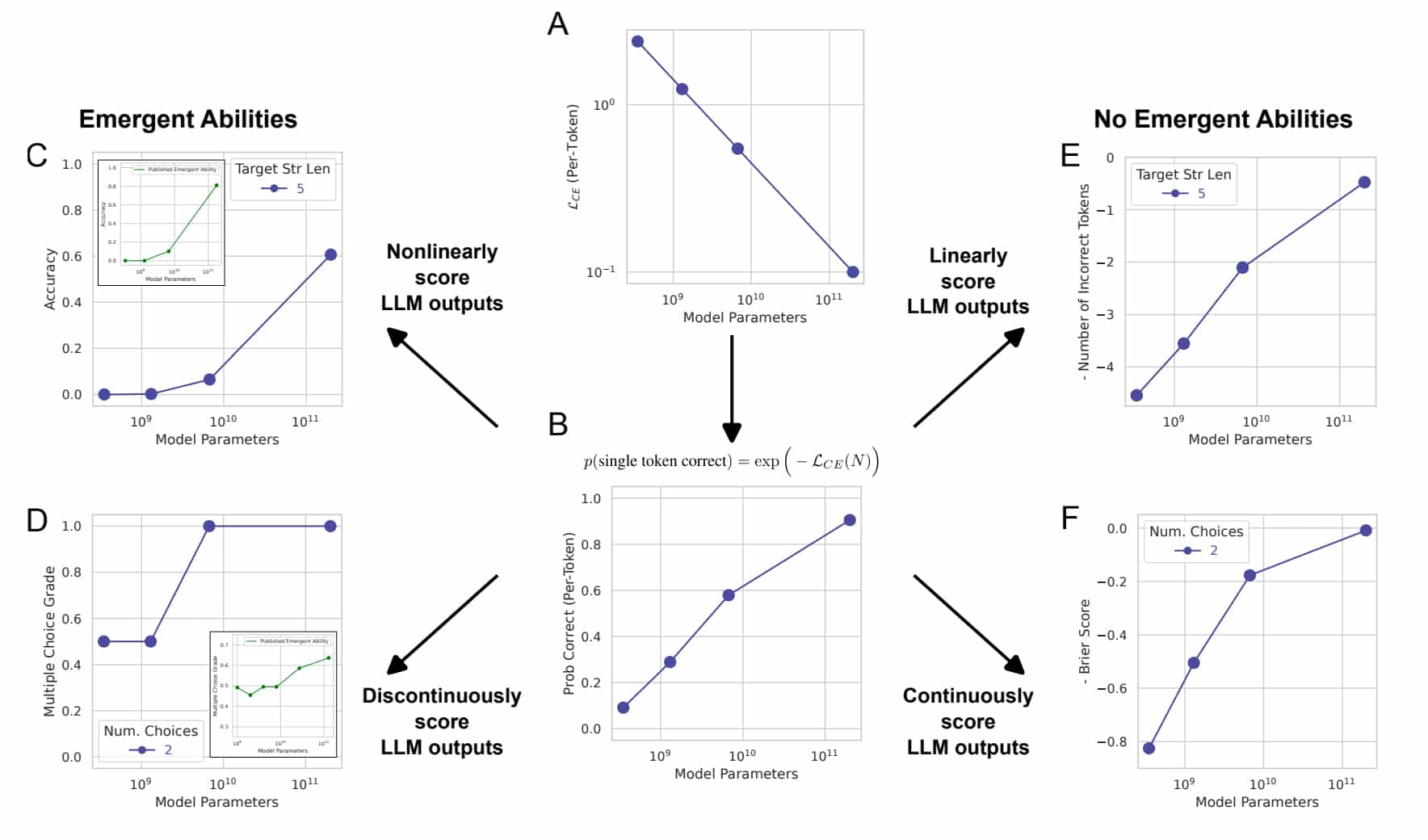

一般に、大規模言語モデルの能力は、予測総数のうち正しい予測の割合である「精度」で測定される。この指標は非線形であるため、精度の変化がジャンプとして捉えられると研究チームは述べている。

「私たちの別の説明では、出現した能力は、主に研究者がトークンごとのエラーレートを非線形または不連続に変形させる指標を選択することによって、また部分的には、小さなモデルの性能を正確に推定するにはテストデータが少なすぎること(それによって小さなモデルが完全にタスクを実行できないように見える)、部分的には大規模モデルの評価数が少なすぎることによって引き起こされる幻想だと仮定する」と論文では述べている。

トークンエディットディスタンス(あるトークンの並びを別のトークンに変換するために必要な1つのトークンの編集回数の最小値を計算する指標)のような線形指標を使用すると、目に見えるジャンプがなくなり、代わりに、パラメータの数が増加すると、滑らかで連続的で予測できる改善が観察されている。

研究チームは今回の研究で、GPT-3などのモデルの創発的な能力は、このような非線形メトリクスによるものであり、線形メトリクスでは劇的なジャンプが見られないことを示した。また、これまで創発性が測定されていなかったコンピュータビジョンモデルでこの効果を再現している。

研究者は、「選択した指標の意味を理解する必要があり、その選択が予測可能な結果をもたらしたとしても、驚いてはならないことを強調します。具体的な例を挙げると、野球選手をある距離を打つ能力で評価することを想像してみてください。各選手の平均飛距離のような指標を用いると、選手の得点分布は滑らかで連続的なものに見えるかもしれません。しかし、『選手の平均飛距離が325フィート(約1.5メートル)を超えるかどうか』という不連続な指標を選ぶと、多くの選手が0点を獲得し、最高の選手だけが1点を獲得することになります。どちらの指標も有効ですが、後者の指標が不連続な結果を出しても驚かないことが重要です。この理解は、研究者が創発的な能力を評価するために選択する指標について、より情報に基づいた決定を下すための指針となります」と、Motherboardに語っている。

創発的な能力は “おそらく幻想に過ぎない“

「研究チームは、固定されたタスクと固定されたモデルファミリーの場合、研究者は、創発的な能力を生み出すためのメトリックを選択することも、創発的な能力を削ぐためのメトリックを選択することもできる。つまり、創発的な能力は、特定のタスクにおけるモデルファミリーの基本的な特性ではなく、研究者の選択の創造物である可能性がある」と、述べている。

しかし、研究チームは、この研究が、GPT-4のような大規模言語モデルが創発的能力を持ち得ないという意味に解釈されるべきではないと強調している。「むしろ、これまで主張されてきた創発的な能力は、研究者の分析によって引き起こされた蜃気楼である可能性が高いというのが、我々のメッセージだ」。

AI研究にとっては、大規模な言語モデルにおける能力の予測可能性を示すようで、この研究は良いニュースかも知れない。OpenAIもGPT-4に関する報告で、多くのベンチマークでGPT-4の性能を正確に予測できることを示している。

しかし、創発的能力の可能性そのものを否定しているわけではないので、そのような能力がすでに存在するのかどうかが問題となる。その候補のひとつが「数発学習」あるいは「文脈内学習」であろう。この能力は、GPT-3で初めて詳細に実証され、今日のプロンプトエンジニアリングの基礎となったものである。

論文

参考文献

- Vice: Scary ‘Emergent’ AI Abilities Are Just a ‘Mirage’ Produced by Researchers, Stanford Study Says

研究の要旨

最近の研究では、大規模な言語モデルは、より小さなスケールのモデルには存在しない能力が、より大きなスケールのモデルには存在するという、創発的な能力を示すと主張している。創発的能力の興味深い点は、存在しない状態から存在する状態に瞬時に移行する鋭さと、一見予測不可能なモデルスケールで出現する予測不可能性の2点である。ここでは、あるタスクとモデルファミリーにおいて、固定されたモデル出力を分析する際に、創発的能力の推論につながる指標とそうでない指標を選ぶことができるという、創発的能力の代替説明を提示する。このように、私たちの代替案は、既存の創発的能力の主張は、研究者の分析によるものであり、特定のタスクにおけるモデルの挙動がスケールとともに根本的に変化するものではないことを示唆している。(1)InstructGPT/GPT-3ファミリーを用いたメトリック選択の効果について、創発的能力を主張するタスクに対して3つの予測を行い、テストし、確認する。(2)BIG-Benchにおける創発的能力のメタ分析においてメトリック選択に関する2つの予測を行い、テストし、確認する。(3) 多様なディープネットワークアーキテクチャ(畳み込み、オートエンコーダー、変換器)における視覚タスクで同様のメトリック決定によってどのように創発能力が見えるかを示す。3つの分析すべてにおいて、我々は、創発的能力がスケーリングAIモデルの基本的な特性ではない可能性があることを強く支持する証拠を発見した。

コメントを残す