Stability AIは次世代のオープンウエイトAI画像合成モデルである「Stable Diffusion XL 1.0(SDXL)」をリリースした。テキスト記述から斬新な画像を生成することができ、従来のStable Diffusionよりも詳細で高解像度の画像を生成する事が可能になる。

昨年8月にオープンソースリリースで話題を呼んだStable Diffusion 1.4と同様、適切なハードウェアと技術的なノウハウがあれば、誰でもSDXLファイルをダウンロードし、自分のマシンでローカルにモデルを無料で実行することができる。

ローカルで動作させるということは、SDXLモデルへのアクセスにお金を払う必要がなく、検閲の心配もほとんどないということだ。

例えば、Stable Diffusion 1.5では、デフォルトのモデル(インターネットからダウンロードした画像のスクレイプで学習)は、幅広い画像を生成することができるが、よりニッチな被写体ではあまりうまく機能しなかった。それを補うために、世界中の開発者はSD 1.5をカスタムモデル(後にLoRAモデル)に微調整し、ディズニースタイルのアート、アニメのアート、風景、特注のポルノ、有名な俳優やキャラクターの画像など、Stable Diffusionの特定の美学を生成する能力を向上させた。Stability AIは、このようなコミュニティ主導の開発傾向がSDXLでも続くことを期待しており、SDXLのレンダリング機能をベースモデルをはるかに超えて拡張できるようにすることを可能にしている。

内部的に大きなアップデートが実施

他の拡散画像ジェネレーターと同様、SDXLはランダムなノイズから開始し、テキストプロンプトからのガイダンスに基づいてノイズ内の画像を「認識」し、画像を段階的に洗練していく。しかしSDXLは、Stability AIによれば「3倍の大きさのUNetバックボーン」を利用し、以前のStable Diffusionモデルよりも多くのモデルパラメータを使ってトリックを実行する。つまり、SDXLのアーキテクチャは、画像を得るために、より多くの処理を行っているのだ。

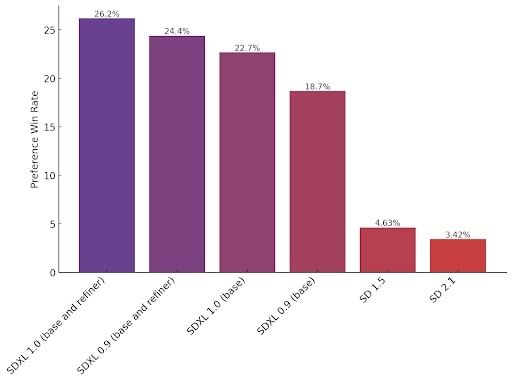

画像を生成するために、SDXLは潜在拡散プロセスをガイドする「アンサンブル・オブ・エキスパート」アーキテクチャを利用する。アンサンブル・オブ・エキスパートとは、最初に単一のモデルをトレーニングし、その後、生成プロセスのさまざまな段階用に特別にトレーニングされた特殊なモデルに分割することで、画質を向上させる手法を指す。この場合、ベースとなるSDXLモデルと、オプションの「リファイナー」モデルがあり、初期生成の後に実行することで、画像の見栄えを良くすることができる。

また、SDXLは2つの異なるテキストエンコーダを使用して、書き込まれたプロンプトの意味を理解し、モデルウェイトにエンコードされた関連イメージを特定するのに役立つ。ユーザーはそれぞれのエンコーダーに異なるプロンプトを与えることができ、その結果、斬新で質の高いコンセプトの組み合わせを生み出すことが可能だ。

そして、画像のディテールとサイズの改善もある。Stable Diffusion 1.5では512×512ピクセルの画像(最適な生成画像サイズだが、小さな特徴のディテールに欠ける)で学習させたが、Stable Diffusion 2.xでは768×768ピクセルに増やした。現在、Stability AIは、Stable Diffusion XLで1024×1024ピクセルの画像を生成することを推奨しており、SD 1.5で生成された同サイズの画像よりもディテールが向上している。

Stable Diffusion XL 1.0 のリリースに合わせて、Stability AI は API の微調整機能をベータ版でリリースしている。これにより、ユーザーはわずか 5 枚の画像を使用して、特定の人物、製品などの生成を「特化」できるようになるという。APIの微調整機能をベータ版としてリリースする。同社はまた、Stable Diffusion XL 1.0を、生成AIモデルをホスティングするためのAmazonのクラウドプラットフォームであるBedrockに提供する。

「最新のSDXLモデルは、Stability AIのイノベーションの伝統と、AIコミュニティのために最先端のオープンアクセスモデルを市場に投入する能力の次のステップを象徴している」とStability AIのCEOであるEmad Mostaque氏はプレスリリースで述べている。

Sources

- Stability AI: ANNOUNCING SDXL 1.0

コメントを残す