OpenAIはDevDayで、GPT-4 Turboといった旗艦モデルのバージョンアップや、様々な新機軸を発表したが。発表された製品の中には、オープンソースの自動音声認識モデル「Whisper large-v3」の拡張版も含まれていたことが判明した。OpenAIの今後の計画には、このモデルのAPIをユーザーが利用できるようにすることが含まれている。

WhisperはOpenAIのオープンソース音声テキスト変換モデルだ。新しいモデルv3は、Whisper v2で収集された100万時間の弱いラベル付き音声と400万時間の擬似ラベル付き音声で学習されている。また、言語として広東語が追加された。ベンチマークでは、モデルv3はエラー率において前モデルを大幅に上回っている。

GitHubで公開されているWhisper large-v3は、寛容なライセンスの下、ユーザーのために様々なコンテンツを簡単に書き起こし、利用可能な最高の書き起こしツールとして認知されている。その際立った特徴のひとつは、YouTubeのようなプラットフォームで字幕として使用するのに理想的な、ユニークなタイムスタンプセクションである。

このツールは、音声を30秒のクリップに分割して変換し、エンコーダーとデコーダーに通すことからテープ起こし作業を開始する。これらのコンポーネントが連携して、対応するテキストキャプションを予測する。これに加えて、言語識別には技術的な複雑さが伴い、多言語音声の書き起こしや英語への翻訳が可能になる。

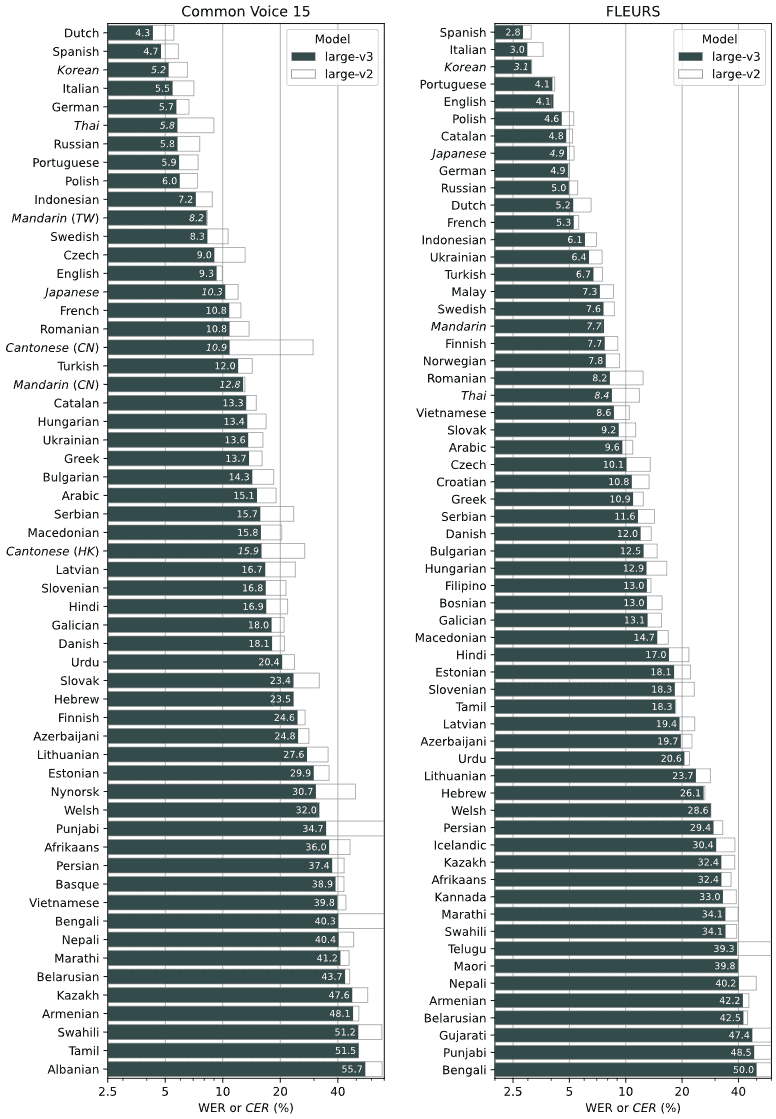

性能は言語によって異なるが、一般的に、Whisper v3の最大バージョンでは、Common Voice 15とFleursのエラー率が60%未満であり、OpenAIによれば、Whisper large-v2よりも10〜20%エラーが減少しているという。

当初は、このモデルをChatGPTと統合し、ユーザーが音声を通じてチャットボットと直接対話できるようにする計画だった。しかし、OpenAIはこのモデルを直接公開することを決定した。興味深いことに、Whisperは現在エンドユーザー向けではなく、研究者向けである。

OpenAIがこのモデルをオープンソース化した理由は、有用なアプリケーションを作成するための強固な基盤を提供し、堅牢な音声処理分野のさらなる研究を奨励するためである。

様々なオンラインソースから、合計68万時間に及ぶ膨大な精度の高いモニタリングデータが収集された。このデータセットの約3分の1は英語以外のソースから得られたものである。

Source

コメントを残す