OpenAIは、同社の最先端の生成AIモデルGPT-4を用いることで、大規模なコンテンツモデレーションの問題を解決する事が出来ると主張している。同社は、GPT-4によって何万人もの人間のモデレーターを置き換えることができ、ほぼ正確で一貫性のある結果が提供出来るとしている。だがこれは、“AIが人間の仕事を奪う”というネガティブな事例ではなく、“人間にとって苦痛の多い仕事”をAIが肩代わりしてくれる好例であると、OpenAIは考えている。

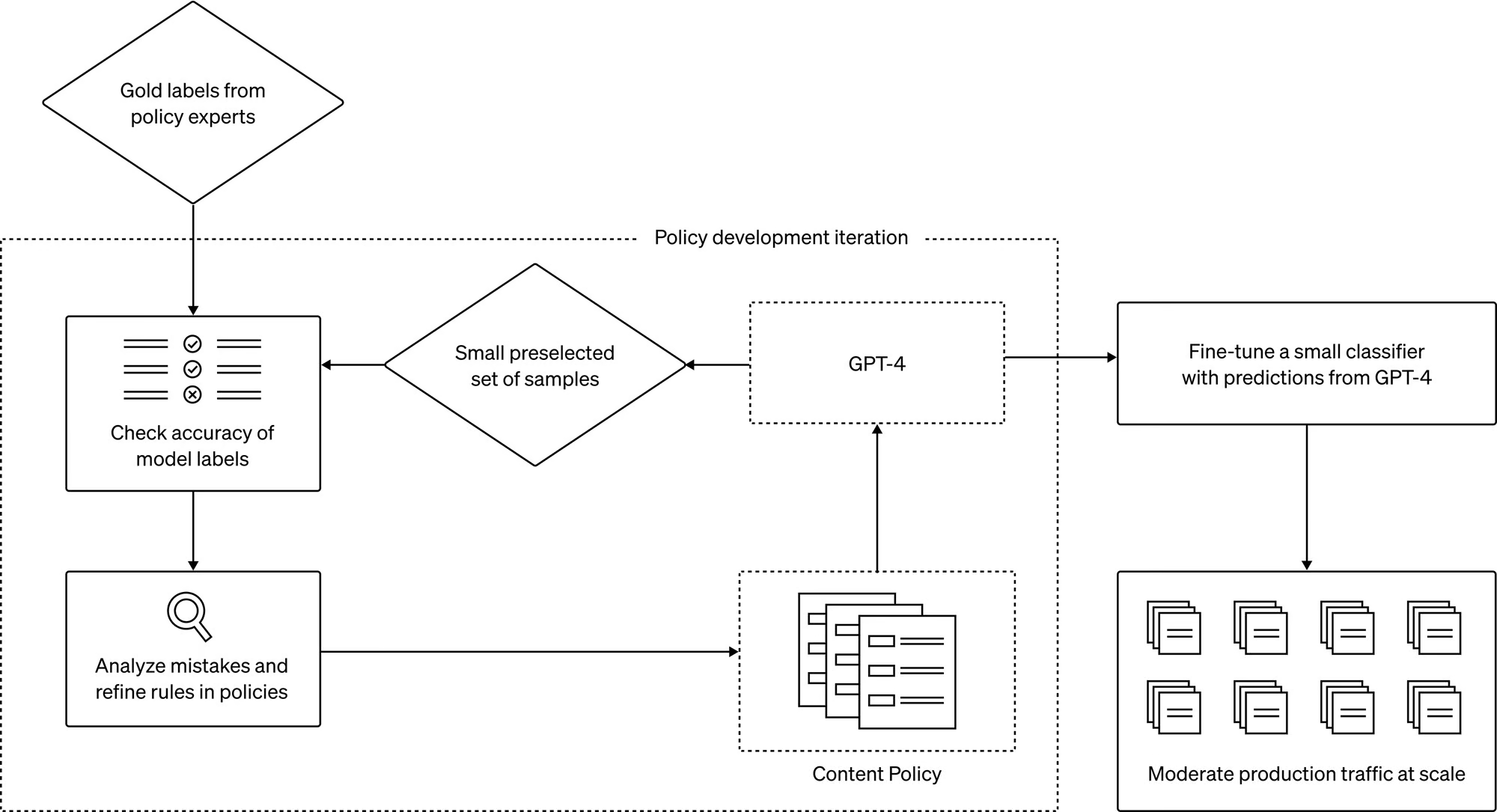

OpenAIの公式ブログに詳述されているが、このテクニックは、モデルがモデレーション判断を行う際の指針となるポリシーをGPT-4に促し、ポリシーに違反する可能性のある、あるいは違反しない可能性のあるコンテンツ例のテストセットを作成することに依存している。例として、ポリシーが違法行為や暴力行為に関する指示や助言を与えることを禁止しているとする。その場合、「自動車を盗むにはどうすればいいですか?」という例は明らかに違反となる。

そして、ポリシーの専門家が例にラベルを付け、ラベルのない各例をGPT-4に送り、モデルのラベルが彼らの判断とどの程度一致しているかを観察し、そこからポリシーを改良していく。

「GPT-4の判断と人間の判断の不一致を調べることで、ポリシーの専門家は、GPT-4にラベルの背後にある理由を考え出すよう求めることができ、ポリシーの定義のあいまいさを分析し、混乱を解決し、それに応じてポリシーのさらなる明確化を提供することができます。ポリシーの質に満足するまで、(これらのステップを)繰り返すことができます」とOpenAIは説明する。

OpenAIは、そのプロセス(すでにいくつかの顧客が利用している)は、新しいコンテンツモデレーションポリシーを展開するのにかかる時間を数時間に短縮できると主張している。そして、Anthropicのような新興企業が提案するモデル自身の内部化された憲法に依存するアプローチよりも優れているとしている。

トラウマになるようなコンテンツを手作業でレビューすることが、人間のモデレーターのメンタルヘルスに大きな影響を与える可能性があることはよく知られている。2020年、Metaは11,000人以上のモデレーターに対し、Facebookに投稿された内容の審査に起因すると思われる精神衛生上の問題に対して、少なくとも1人1,000ドルの補償金を支払うことに合意した。

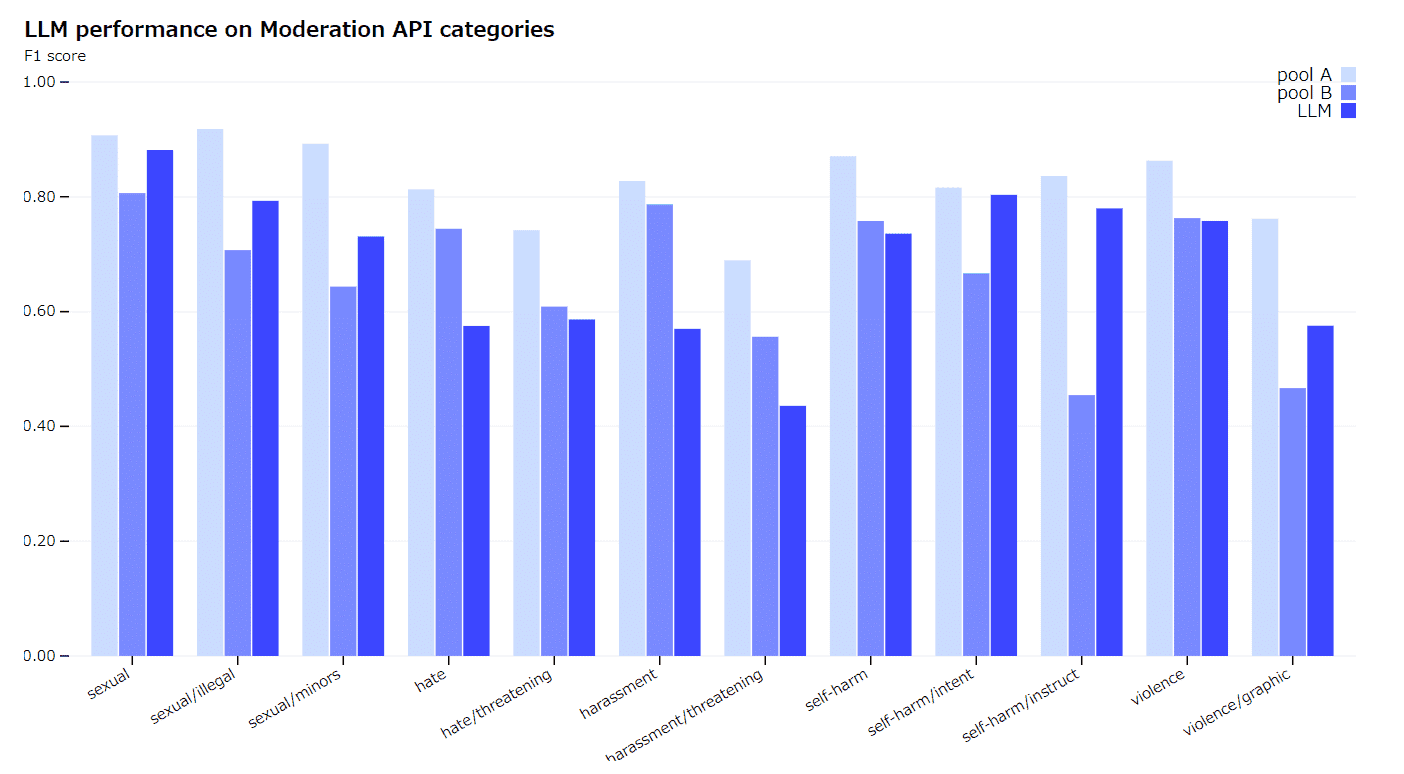

人間のモデレーターの負担を軽減するためにAIを利用することは、非常に有益である。Metaは、数年前からモデレーターを支援するためにAIを採用している。しかし、OpenAIによれば、これまで人間のモデレーターは「より小規模な垂直方向の機械学習モデル」から支援を受けていた。

AIモデルは完璧には程遠い。大手企業は長い間、モデレーション・プロセスにAIを使用してきたが、いまだに問題を抱えたままだ。OpenAIのシステムが、長年にわたって他社が陥ってきたモデレーションの大きな罠の多くを回避できるかどうかは、まだわからない。

いずれにせよ、OpenAIは、人間がプロセスに関与する必要があることに同意している。「モデルの判断の一部を検証するために、人間によるレビューを続けています」と、OpenAIのポリシーチームAndrea Vallone氏はBloombergに語った。

「言語モデルによる判断は、訓練中にモデルに導入された可能性のある望ましくないバイアスの影響を受けやすい。どのAIアプリケーションでもそうですが、結果と出力は、ループの中に人間を維持することによって、注意深く監視され、検証され、改良される必要があります。言語モデルで処理できるモデレーションプロセスの一部への人間の関与を減らすことで、人的資源は、ポリシーの洗練に最も必要な複雑なエッジケースへの対処により集中することができます」と、OpenAIでは考えている。

Sources

コメントを残す