OpenAIは、AIが何かをでっち上げる“幻覚”と呼ばれる一般的な問題を排除するために行ったいくつかの進歩の概要を示す新しい論文を発表した。この論文では、幻覚を取り除くための結果監視(outcome supervision)とプロセス監視(process supervision)と呼ばれる2つのモデルの概要と、その性能について説明している。

結果監視では、OpenAIは報酬モデルを訓練し、AIが与える最終結果についてフィードバックを提供する。プロセス監視では、報酬モデルがすべてのステップでフィードバックを提供し、人間のような思考の連鎖を作り出す。

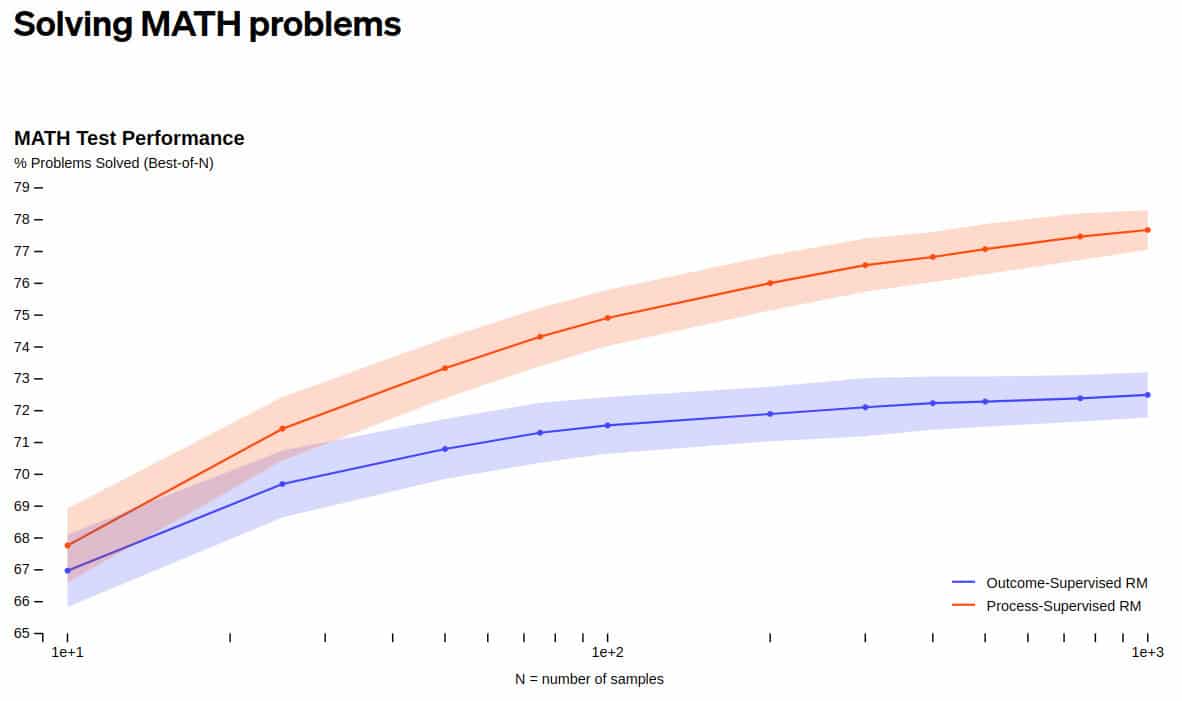

OpenAIは論文の中で、数学のデータセットで両モデルをテストし、プロセス監視方式が「著しく優れたパフォーマンス」につながることを明らかにした。プロセス監視方式は今のところ数学の分野でしかテストされておらず、より一般的にどのようなパフォーマンスを発揮するかはもっと研究が必要であることに留意する必要がある。

プロセス監視方式で考えられる成果について、OpenAIは次のように説明する:

“この結果が一般化すれば、プロセス監視は、結果監視よりもパフォーマンスが高く、かつ整合性のある方法という、両方の長所を与えてくれることがわかるかもしれません。”

この段階的な検証が、より一般的な幻覚への対処にどれほど役立つかを語るのはまだ早いが、ちょうど、ChatGPTを仕事に使っていた弁護士が、AIがでっち上げた偽の判例を提出し問題になったこともあり、幻覚はおそらく今、LLMの1番の問題なので、解決に繋がることが期待される。

OpenAIは、公開されているChatGPTにプロセス監視を実装するためにどれくらいの時間がかかるか、スケジュールを示していない。まだ研究段階であり、一般的な情報でのテストが必要だ。

初期の結果は良好だが、OpenAIは、より安全な方法はアライメントタックスと呼ばれる性能低下が発生する可能性があることに言及している。今のところ、数学の問題でプロセス監視がこのタックスを発生させないという結果が出ているが、より一般的な情報でどうなるかは分からない。

また、OpenAIは、関連研究を支援するために、80万個のステップレベルの人間のフィードバックラベルからなる完全なデータセットであるPRM800KをGitHubにて公開している。

論文

- OpenAI: Let’s Verify Step by Step (PDF)

参考文献

研究の要旨

近年、大規模な言語モデルは、複雑な多段階推論を行う能力が大きく向上している。しかし、最新のモデルであっても、定期的に論理的な誤りを起こすことがある。より信頼性の高いモデルを開発するためには、最終的な結果に対するフィードバックを提供する結果監視と、推論途中の各ステップに対するフィードバックを提供するプロセス監視のいずれかに頼る必要がある。信頼性の高いモデルを訓練することの重要性と、人間によるフィードバックのコストの高さを考えると、両者の方法を注意深く比較することが重要である。最近の研究により、この比較はすでに始まっているが、まだ多くの疑問が残っている。我々は独自の調査を行い、難易度の高いMATHデータセットの問題を解決するモデルの訓練において、プロセス監視が結果監視を大幅に上回ることを発見した。を解くモデルの学習において、プロセス監視が結果監視を大きく上回ることを発見した。我々のプロセス監視モデルは、MATHデータセットの代表的なサブセットの問題の78%を解決することができた。さらに 能動学習がプロセス監視の有効性を著しく向上させることを示す。また、関連研究を支援するために、80万個のステップレベルの人間のフィードバックラベルからなる完全なデータセットであるPRM800Kを公開する。

コメントを残す