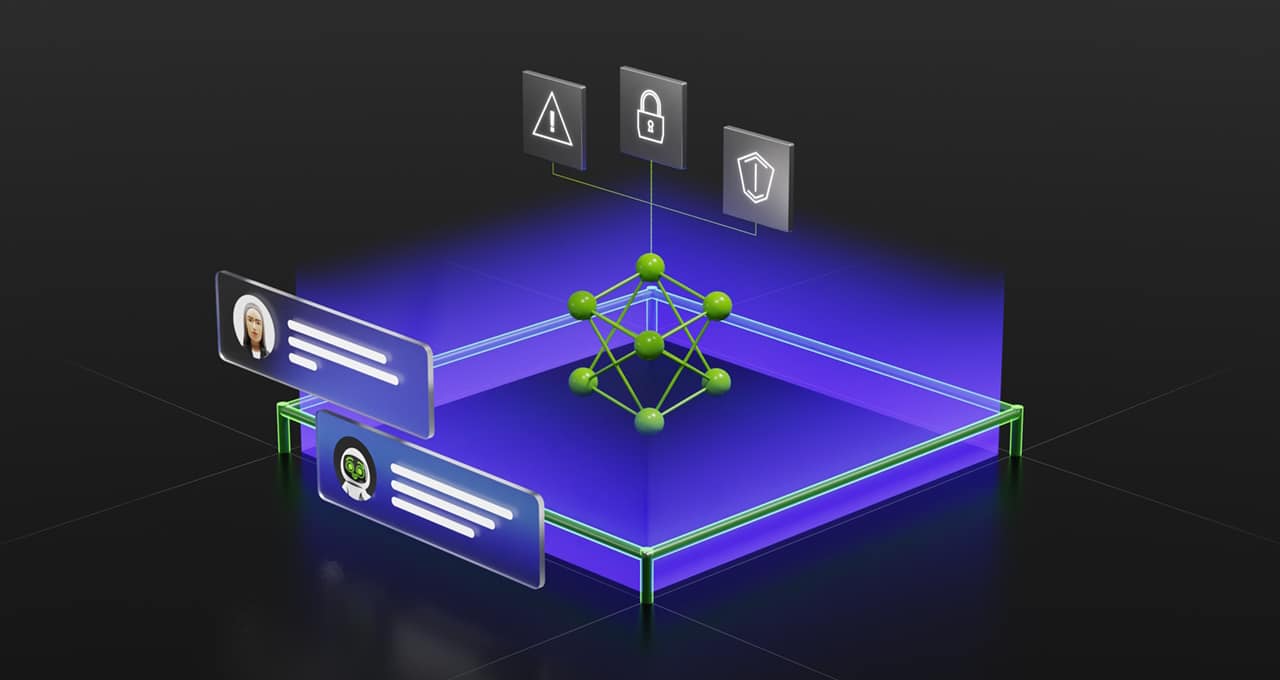

NVIDIAは3月より、企業が独自のデータで大規模言語モデル(LLM)をトレーニングできるサービス「AI Foundations」を提供していたが、本日、同社は、開発者が生成AIアプリの正確性、適切性、安全性を確保するために設計されたツール「NeMo Guardrails」を発表した。

NeMo Guardrailsは、ソフトウェアエンジニアが社内のLLMに以下のように3種類の制限をかけることが出来る様になった:

- アプリが望ましくない領域に逸脱してしまうのを防ぐのが、局所的なガードレールです。例えば、カスタマーサービスが天気に関する質問に答えないようにするためです。

- 安全ガードレールは、アプリが正確で適切な情報で応答することを保証します。不要な言葉を排除し、信頼できる情報源にのみ言及するよう強制することができます。

- セキュリティガードレールは、アプリが安全であることが分かっている外部のサードパーティアプリケーションにのみ接続するよう制限します。

NVIDIAによると、NeMo GuardrailsはChatGPTを含むすべてのLLMで動作する。しかも、同社は、ほぼすべてのソフトウェア開発者が使用できるとしている。「機械学習の専門家やデータサイエンティストである必要はありません」と、同社は述べている。NeMo Guardrailsはオープンソースであるため、企業の開発者がすでに使用しているすべてのツールでも動作するとNVIDIAは指摘している。

NVIDIAは、生成AIモデルを構築するための既存のNeMoフレームワークにNeMo Guardrailsを組み込んでいる。企業顧客は、同社のAIエンタープライズ・ソフトウェア・プラットフォームを通じてNeMoにアクセスすることが出来る。また、NVIDIAは、AI Foundationsサービスを通じて、このフレームワークを提供している。NeMo Guardrailsのリリースは、Microsoft BingやGoogle Bardなど、最も注目されている生成AIのいくつかが、情報を「幻覚」する傾向があるとして批判の的になっていることを受けてのことだ。実際、Googleのチャットボットは、最初の公開デモで事実誤認を起こし、評判を著しく損なっている。

Source

コメントを残す