先日、NVIDIAは空前のAIブームの波に乗り、まさにゴールドラッシュで1人大量のスコップを売りさばいている同社は、データセンター向けコンピュートGPUで1四半期に100億ドル以上を稼いだばかりだが、この件に詳しい情報筋の話を引用したFinancial Timesの報道によると、その生産量を3倍にする計画のようだ。

この計画は非常に野心的であり、もしNVIDIAがこれを成功させ、人工知能(AI)やハイパフォーマンス・コンピューティング(HPC)アプリケーション向けのA100、H100、その他のコンピュートCPUの需要が好調を維持すれば、まさに同社にとって空前の好景気をもたらす可能性がある。

NVIDIAのフラッグシップGPUであるH100の需要は非常に高く、2024年までバックオーダーが積み上がっている状態のようだ。Financial Timesによると、2024年のH100出荷予測は150万〜200万個で、今年予想される50万個から大幅に増加すると、この件に詳しい情報筋からの話を引用している。

NVIDIAのCUDAフレームワークはAIとHPCワークロード向けに調整されているため、NVIDIAのコンピュートGPUでしか動作しないアプリケーションは何百とある。AWSとGoogleの両社は、AIのトレーニングや推論ワークロード用に独自のカスタムAIプロセッサーを持っているが、クライアントがNVIDIAのコンピュートGPUでアプリケーションを実行することを望むため、NVIDIAのコンピュートGPUを大量に購入しなければならない。

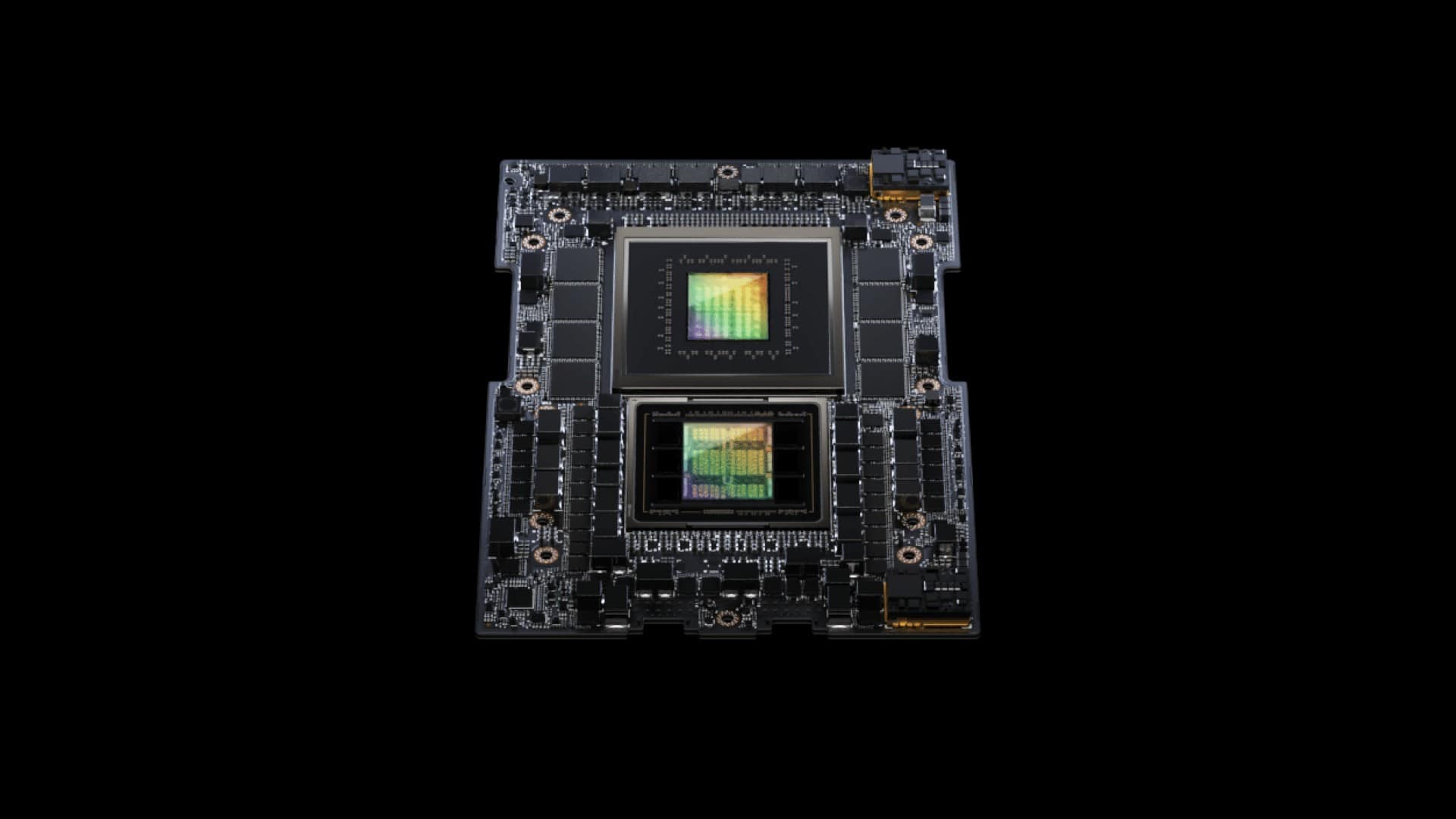

しかし、NVIDIA H100コンピュートGPU、GH200 Grace Hopperスーパーコンピューティング・プラットフォーム、およびその基盤製品の供給を増やすことは容易ではない。NVIDIAのGH100は複雑なプロセッサーで、製造はかなり難しい。出力を3倍にするためには、いくつかのボトルネックを取り除かなければならない。

まず、GH100コンピュートGPUは814mm2の巨大なシリコンであるため、大量生産はかなり難しい。現在、同製品の歩留まりはそれなりに高いと思われるが、NVIDIAがGH100ベースの製品の生産量を3倍にするには、TSMCから大量の4Nウェハー供給を確保する必要がある。大雑把に見積もっても、TSMCとNVIDIAが300mmウェハあたり最大65個のチップを供給できることになる。

このようなチップを200万個製造するには、約3万1,000枚のウェハーが必要になる。確かに可能ではあるが、TSMCの5nmクラスウェハーの総生産量(月産約15万枚)のごく一部である。この生産能力は現在、AMD CPU/GPU、Apple、NVIDIA、その他の企業で共有されている。

第2に、GH100はHBM2EまたはHBM3メモリに依存し、TSMCのCoWoSパッケージを使用するため、NVIDIAはこの面でも供給を確保する必要がある。現在、TSMCはCoWoSパッケージの需要を満たすのに苦労している。

第3に、H100ベースのデバイスはHBM2E、HBM3、またはHBM3Eメモリを使用するため、NvidiaはMicron、Samsung、SK hynixなどの企業から十分なHBMメモリパッケージを調達する必要がある。

最後に、NVIDIAのH100コンピュートカードまたはSXMモジュールはどこかにインストールされなければならないため、NVIDIAはパートナーもAIサーバーの出力を少なくとも3倍にする必要がある。

しかし、もしNVIDIAが必要なH100 GPUをすべて供給することができれば、NVIDIAは来年、この取り組みで巨額の利益を上げることができるだろう。

Sources

- Financial Times: Supply chain shortages delay tech sector’s AI bonanza

- via Tom’s Hardware: Nvidia to Reportedly Triple Output of Compute GPUs in 2024: Up to 2 Million H100s

コメントを残す