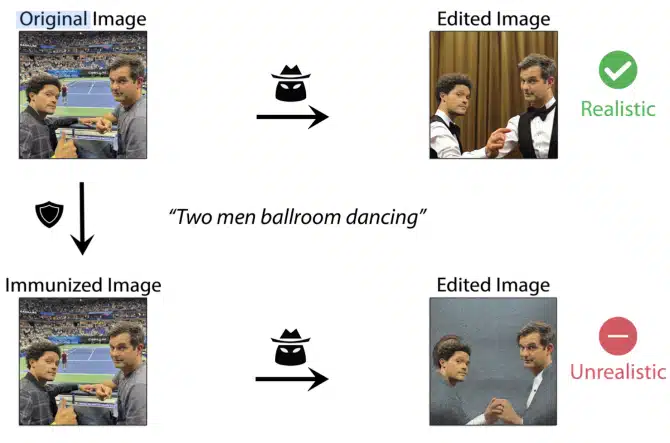

人工知能の台頭とともに、プライバシーや偽情報に関する新たな懸念が生じている。画像をスクリーンショットして編集することは誰にでもできるが、それには時間と労力、そしてスキルが必要だ。だが、画像生成AIを使えばそれらがなくなるため、悪意のある写真操作に対する敷居が低くなり、そうしたコンテンツが蔓延する可能性が高まる。これに先んじるため、マサチューセッツ工科大学(MIT)の博士課程の学生グループは、AIを活用した編集の試みに対して写真を「保護」するツールを開発した。

PhotoGuardと呼ばれるこのツールは、2つの異なる戦略を用いてAIから画像を保護する。ひとつは「エンコーダー」と呼ばれる方法で、画像内のピクセルの位置や色などの複雑な情報を取り込む。もうひとつは「拡散」と呼ばれるもので、一握りのピクセルを選択し、人間の目には見えない程度に修正する。どちらも、AIが対象画像を理解しようとする試みを混乱させ、あるもの(例えば、人物の写真)をまったく別のもの(平坦な灰色の正方形など)として認識させる。これにより、AIは元の画像に意味のある編集を加えることができなくなる。

PhotoGuardの変更はほとんど気づかれないため、写真の完全性を保護するためにこのツールを使用している人は、お気に入りの画像をソーシャルメディアで共有することができる。しかし、PhotoGuardの作者がMITのMadry Labが運営するGradient Scienceに寄稿したブログ投稿によると、それは真の目的ではない。「その代わりに、モデルを提供する企業自身が、自分の画像を編集から守るためのAPIを提供してくれることを望んでいます」と、彼らは語る。

PhotoGuardを試してみたい人は、HuggingFaceのインタラクティブなデモを使って試すことができる。

AIからコンテンツを保護する方法に取り組んでいるのは、MITだけではない。シカゴ大学のコンピューター科学者チームは2月、AIアートジェネレーターが人間のアーティストのコンテンツをスクレイピングして作品を盗用するのを防ぐ「Glaze」と呼ばれるツールを発表した。同チームはその後、Glazeをダウンロードできるようにし、さらに一般の人々が簡単に使えるようにツールをアップデートした。

Sources

- Gradient Science: Raising the Cost of Malicious AI-Powered Image Editing

- via Endgadget: MIT’s ‘PhotoGuard’ protects your images from malicious AI edits

コメントを残す