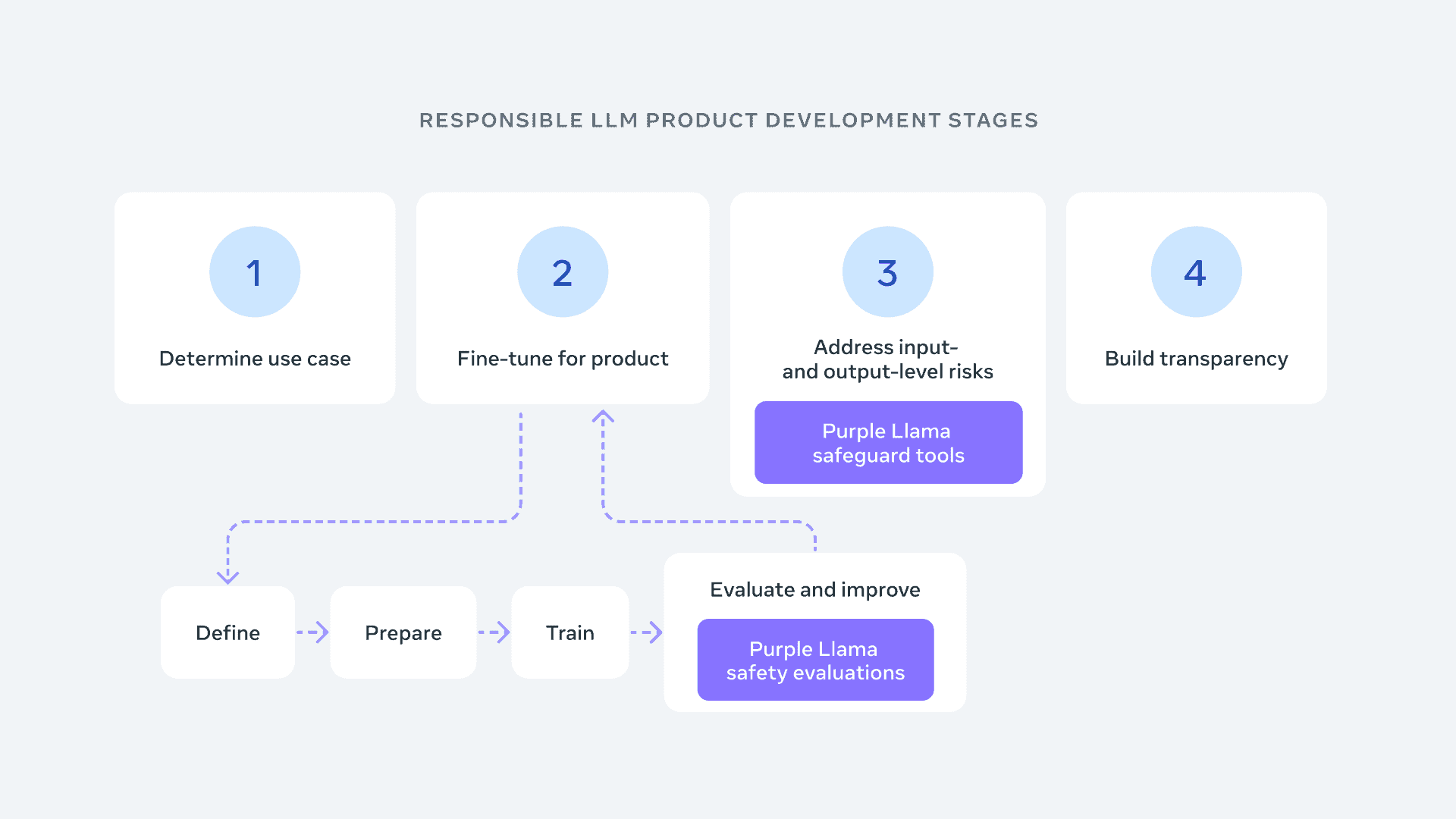

Meta AIは、責任ある生成AI開発のためのオープンな信頼と安全ツールを提供し、”競争の場を平準化する”ことを目的とした包括的プロジェクト、「Purple Llama」を立ち上げた。

このプロジェクトは、開発者が責任を持ってオープンな生成AIモデルを構築するためのツールと評価を提供するもので、当初はサイバーセキュリティと入出力のセーフガードに重点を置く。このプロジェクトは、同社のグローバルアフェアーズ責任者であり、元英国副首相のNick Clegg氏によって木曜日に発表された。

Metaは、「安全性に関する協力は、この新しい革新の波を推進する開発者たちへの信頼を築くために必要であり、責任あるAIに関する追加の研究と貢献が必要です。AIシステムを構築する人々は、AIの課題に対処するために孤立しているわけではないため、オープンな信頼と安全性のための中心地を作り、プレイングフィールドを平準化したい」と述べている。

Purple Llamaの下で、Metaは他のAIアプリケーション開発者と協力している。これには、AWSやGoogle Cloudのようなクラウドプラットフォーム、Intel、AMD、NVIDIAのようなチップデザイナー、Microsoftのようなソフトウェア企業が含まれる。これらの企業は、モデルの能力をテストし、安全リスクをチェックするためのツールをリリースする。Purple Llamaプロジェクト内のコンポーネントは、研究と商用利用の両方を可能にする許容的なライセンスで提供される。

サイバーセキュリティに関しては、LLMのサイバーセキュリティ安全性評価の業界全体の最初のセットを共有している。これらのベンチマークは、業界のガイダンスと標準(例えば、CWEやMITRE ATT&CK)に基づいており、セキュリティの専門家との協力で構築されている。この初期リリースでは、ホワイトハウスの責任あるAIの開発に関するコミットメントで概説されているいくつかのリスクに対処するのに役立つツールを提供することを目指している。これには、以下が含まれる:

- LLMのサイバーセキュリティリスクを定量化するための指標。

- 不安全なコード提案の頻度を評価するためのツール。

- 悪意のあるコードの生成を困難にし、サイバー攻撃の実行を支援するためのLLMの評価ツール。

最初に公開されたパッケージには、ソフトウェア生成モデルのサイバーセキュリティ問題をテストするツールと、不適切または暴力的、違法な活動について議論するテキストを分類する言語モデルが含まれている。

CyberSec Evalと呼ばれるこのパッケージは、AIモデルが不安全なコードを生成する可能性がどの程度あるか、またはユーザーがサイバー攻撃を実行するのを支援する可能性がどの程度あるかをチェックするベンチマークテストを実行することを可能にする。

例えば、開発者は自分たちのモデルにマルウェアを作成するよう指示し、それが要求にどの程度従うかを確認し、そのような要求をブロックすることができる。または、一見無害なタスクを実行するようモデルに依頼し、それが不安全なコードを生成するかどうかを確認し、モデルがどのように誤動作しているかを把握しようとすることもできる。

初期のテストでは、大規模な言語モデルが平均して30%の確率で脆弱なコードを提案していることが、Metaの研究者によって明らかにされた。これらのサイバーセキュリティベンチマーク評価は繰り返し実行され、モデルへの調整が実際にそれらをより安全にしているかどうかをチェックすることができる。

プロジェクトとしてもう一つリリースされた「Llama Guard」は、テキストを分類するために訓練された大規模言語モデルである。これは、性的に露骨な言葉、攻撃的な言葉、有害な言葉、または違法な活動についての議論を探す。開発者は、自分たちのモデルが安全でないテキストを受け入れたり生成したりするかどうかをテストするために、Llama Guardによって生成された入力プロンプトと出力応答を実行することができる。その後、モデルが不適切なコンテンツを生成する可能性がある特定の項目をフィルタリングすることができる。

Metaは、Purple LlamaをAIの入力と出力の両方を見るセキュリティと安全性の二本立てのアプローチと位置付けている。「生成AIが提示する課題を真に緩和するためには、攻撃(レッドチーム)と防御(ブルーチーム)の両方の姿勢を取る必要があると私たちは信じている。パープルチーミングは、レッドチームとブルーチームの両方の責任を持つ協力的なアプローチであり、潜在的なリスクを評価し、軽減する」と述べている。

Sources

コメントを残す