Metaの人工知能部門であるMeta AIは、「CM3leon(カメレオンと発音)」と名付けられた新しいマルチモーダルモデルを開発した。この革新的なモデルは、テキストと画像の両方を理解し、生成することが出来るという。つまり、テキストの説明から画像を作成したり、画像に基づいてテキストを構成したりすることができ、ユーザーがビジュアルコンテンツと対話し、操作する方法に革命をもたらすものだ。

この、「テキスト」と「画像」の双方向への変換が可能であるモデルは、現在のところ、このCM3leonだけであり、更にCM3leonは、テキストのみの言語モデルを応用したレシピで学習させた最初のマルチモーダルモデルでもあるという。

CM3Leonのアーキテクチャは、テキストベースのモデルと同様に、デコーダのみのトークナイザベースの変換ネットワークを使用している。これは以前の研究(RA-CM3)を基にしたもので、「検索補強」と呼ばれ、学習時に外部データベースを利用する。他のモデルは、与えられた生データから学習するだけかもしれないが、検索補強を備えたモデルは、学習プロセスにおいて最も関連性の高い多様なデータを学習中に積極的に探し出すため、学習段階がよりロバストで効率的になる。

CM3leonは“マルチ”なタスクに対応する

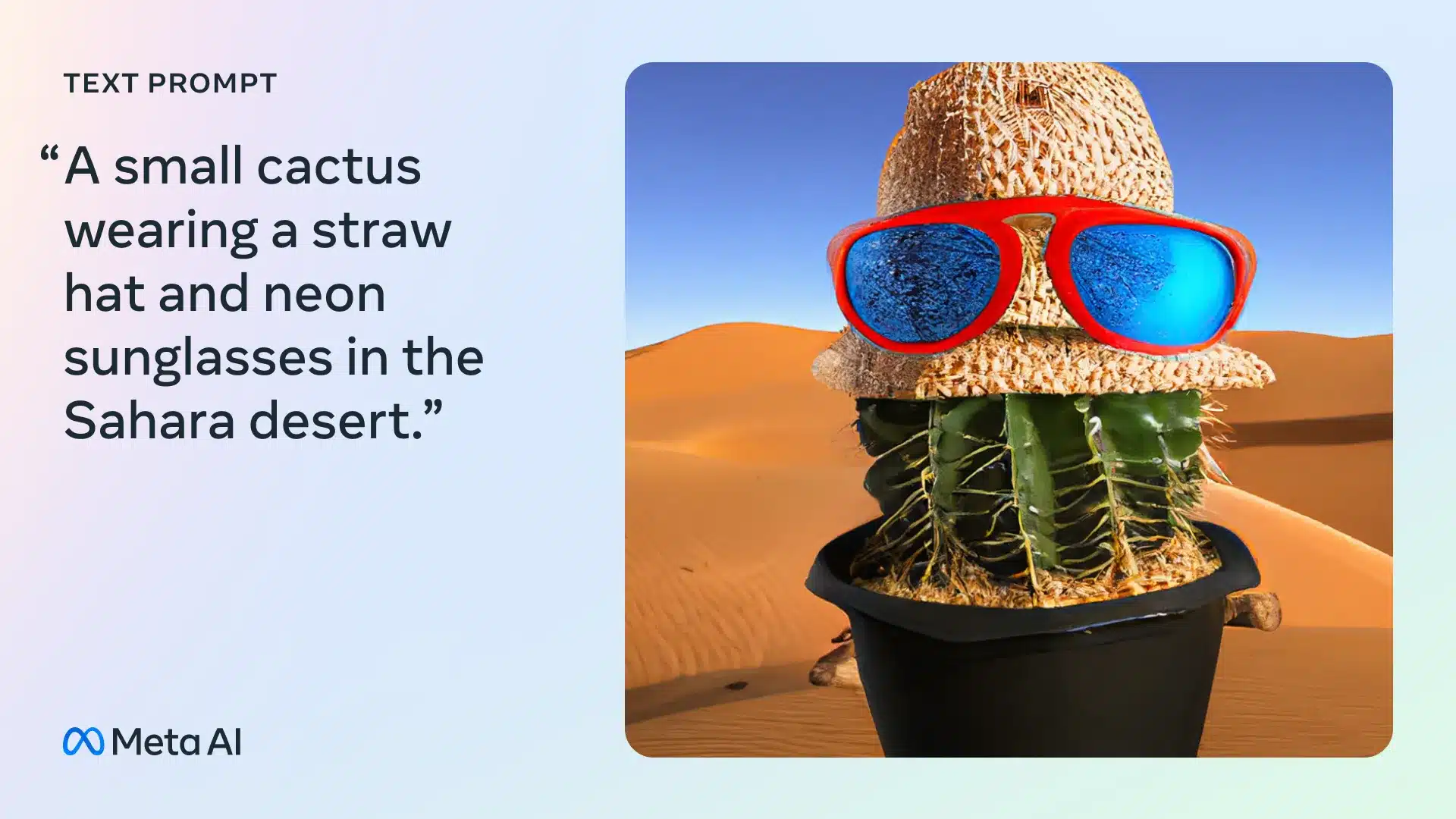

大規模なマルチタスク命令チューニングにより、CM3leonは、テキストガイド付き画像生成・編集、テキストから画像への生成、テキストガイド付き画像編集、キャプション生成、ビジュアル質問応答、構造ガイド付き画像編集など、さまざまなタスクを実行できる。

CM3Leonをトレーニングするために、MetaはShutterstockからライセンスされた数百万の画像のデータセットを使用した。Metaが構築したCM3Leonのいくつかのバージョンの中で最も高性能なものは、DALL-E 2の2倍以上である70億のパラメーターを持っている。(パラメーターとは、学習データから学習されたモデルの部分であり、基本的には、テキストを生成するような問題、この場合は画像を生成するような問題に対するモデルのスキルを定義するものである)

CM3Leonのパフォーマンス向上の鍵のひとつは、SFT(Supervised Fine-Tuning)と呼ばれるテクニックである。SFTは、OpenAIのChatGPTのようなテキスト生成モデルのトレーニングに使用され、大きな効果を上げている。実際、命令チューニングにより、CM3Leonは画像生成だけでなく、画像キャプションの作成でも性能が向上し、画像に関する質問に答えたり、テキスト命令(例えば「空の色を明るい青に変えてください」)に従って画像を編集したりできるようになった。

画像生成ベンチマーク(ゼロショットMS-COCO)において、CM3leonはFréchet Inception Distance (FID)スコア4.88を達成しているが、これは現時点で最高性能を誇る結果であり、GoogleのParti画像モデルを凌駕している。

一貫性、ライセンス、メタバースが向上

Metaによると、CM3leonは、複雑な入力命令にもよく従うコヒーレントな画像を生成することに優れている。CM3leonは、大域的な形状や局所的なディテールをよりよく復元し、プロンプトに表示されるテキストや数字を生成し、Instruct Pix2Pixのような特殊なモデルを必要としていたテキストガイド付き画像編集のようなタスクを解決することができる。

CM3leonは、テキストガイドによる画像生成と編集のための高度な機能を備えている。入力プロンプトに密接に沿った首尾一貫した画像を生成することができ、効率性の点で他のモデルとは一線を画している。従来のトランスフォーマーベースの手法に比べ、5倍の計算能力と少ない学習データセットしか必要としないのだ。

このモデルは、視覚的質問応答や長文のキャプション付けなど、様々な視覚言語タスクにおいて優れている。これは、画像生成で一般的に使用されている拡散法からの脱却を意味する。その代わりに、Metaの研究者は、OpenAIのGPT-4 StyleSwinのような大規模言語モデルで実装に成功したことで知られるニューラルネットワーク設計であるトランスフォーマーアーキテクチャを選択した。

Metaによると、CM3leonは、複雑な入力指示にもよく従う首尾一貫した画像を生成することに優れている。CM3leonは、グローバルな形状とローカルなディテールをよりよく復元し、プロンプトに表示されるテキストや数字を生成し、Instruct Pix2Pixのような特殊なモデルを必要としていたテキストガイド付き画像編集のようなタスクを解決することができる。

CM3leonはまた、画像に詳細なキャプションを書き込むこともできる(逆促進)。Metaによれば、CM3leonは、より少ないテキスト(30億テキストトークン)で学習されたにもかかわらず、テキストタスクではFlamingoとOpenFlamingoに匹敵するか、勝っているという。

最も注目すべきは、このモデルが「ライセンスされた画像とテキストデータのみを含む、新しい大規模なShutterstockデータセット」で訓練されたものであることだが、それでも他のモデルと比較して非常に競争力があるとMetaは言う。

「その結果、パフォーマンスを犠牲にすることなく、画像の所有権や帰属に関する懸念を回避することができる」と彼らは書いている。

Metaによれば、CM3leonはより忠実度の高い画像生成と理解への一歩であり、マルチモーダル言語モデルへの道を開くものだという。CM3leonのようなモデルは、「最終的にはメタバースにおける創造性とより良いアプリケーションを後押しすることができる」と述べており、同社がまだメタバースへの夢を諦めていないことを匂わせている。

だが、このモデルは最先端の機能を備えているにもかかわらず、クローズドソースであるために研究コミュニティから批判を浴びている。これは、先月同社がVoiceboxを発表した際にも同様の動きがあったことに続くものだ。Google、Microsoft、Meta、Amazon、Appleといったハイテク大手については、批判も多い。その最たる物はこれらの企業は、オープンソースコミュニティから多大な恩恵を受けているが、研究のかなりの部分を自分たちだけのものにしているからだ。

論文

参考文献

- Meta AI: Introducing CM3leon, a more efficient, state-of-the-art generative model for text and images

研究の要旨

CM3Leon(カメレオンと発音)は、テキストと画像の両方を生成して埋め込むことができる、検索を強化したトークンベースのデコーダのみのマルチモーダル言語モデルである。CM3LeonはCM3マルチモーダルアーキテクチャを使用していますが、さらに、より多様なインストラクションスタイルのデータに対して、スケールアップとチューニングを行うことの非常に大きな利点を示しています。これは、テキストのみの言語モデルから適応されたレシピで学習された最初のマルチモーダルモデルであり、大規模な検索で補強された事前学習ステージと、2番目のマルチタスク教師付き微調整(SFT)ステージを含む。また、テキストから画像への生成と画像からテキストへの生成の両方が可能な汎用モデルであるため、高品質な出力を生成する自己完結型のコントラストデコーディング手法を導入することができる。広範な実験により、このレシピがマルチモーダルモデルに非常に有効であることが実証されている。CM3Leonは、同等の手法よりも5倍少ない学習量で、テキストから画像への生成において最先端の性能を達成した(ゼロショットのMS-COCO FIDは4.88)。SFTの後、CM3Leonは、言語ガイドによる画像編集から画像制御による生成やセグメンテーションに至るまで、前例のないレベルの制御性を示すこともできる。

コメントを残す