スタンフォード大学、カリフォルニア大学バークレー校、そしてSamaya AIの研究者たちは、大規模言語モデル(LLM)における興味深い現象を発見した。それは、人間のプライマシー/リセンシー効果に似ており、人々が声明の最初と最後の内容を記憶しやすい一方で、中間の内容は見落とされがちであるというものである。

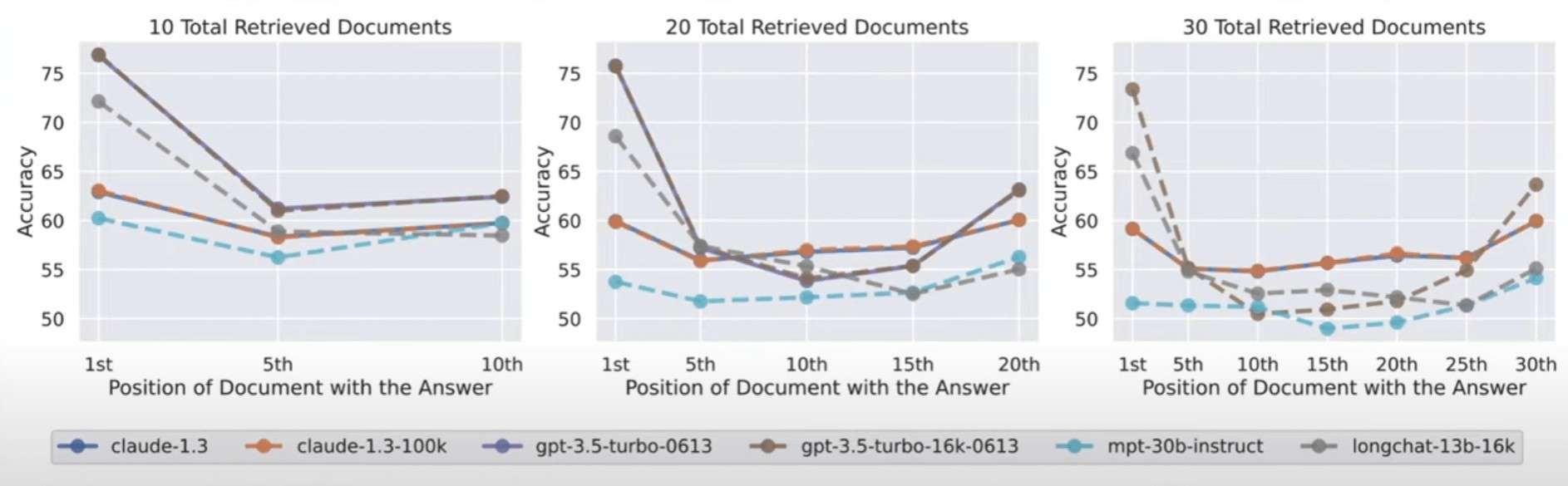

この研究によれば、大規模言語モデルも同様の効果が見られる。入力から情報を取り出すよう求められた場合、モデルは入力の最初または最後にある情報を最もうまく処理する。しかし、関連する情報が入力の中間にある場合、パフォーマンスは大幅に低下する。このパフォーマンスの低下は、モデルが複数の文書から情報を抽出して質問に答える必要がある場合に特に顕著である。これは、学生が試験の質問に答えるために複数の本から関連情報を特定する必要がある状況に相当する。

モデルが同時に処理しなければならない入力が多いほど、そのパフォーマンスは悪化する傾向にある。これは、大量の情報を同時にかつ均等に処理することが重要な実世界のシナリオでは問題になる可能性がある。

また、この結果は、大規模言語モデルが追加情報をどれだけ効果的に使用できるかには限界があることを示唆している。特に詳細な指示を含む「メガプロンプト」は、より害になる可能性が高い。

大きなコンテキストウィンドウを持つLLMの有用性

「中間の紛失」現象は、多くのコンテキストを扱うように特別に設計されたモデルにおいても発生する。例えば、GPT-4 32KやClaudeの100Kトークンのコンテキストウィンドウなどがそれである。

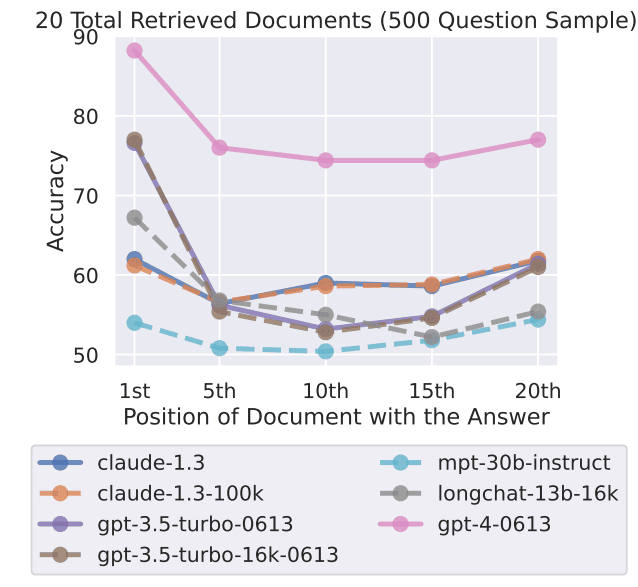

研究者たちは、新しいGPT-3.5 16KやClaude 1.3の100Kを含む7つのオープンおよびクローズド言語モデルをテストした。すべてのモデルは、テストによって異なる程度のU字型のカーブを示し、テキストの最初または最後に解決策があるタスクでより良いパフォーマンスを示した。

このことは、大きなコンテキストウィンドウを持つモデルの有用性に疑問を投げかける。コンテキストを小さなチャンクで処理する方が良い結果が得られる可能性がある。現在のリーディングモデルであるGPT-4もこの効果を示しているが、全体的なパフォーマンスレベルは高い。

研究チームは、モデルが言語をどのように処理するかについてはまだ完全には理解されていないと認めている。この理解を新しい評価方法を通じて改善する必要があり、新しいアーキテクチャも必要になるかもしれない。

また、プロンプトの設計がモデルのパフォーマンスにどのように影響するかについても研究する必要がある。タスクに対するAIシステムの認識をプロンプトで高めることで、関連情報を抽出する能力を向上させることができるかもしれない。

論文

研究の要旨

最近の言語モデルは長い文脈を入力として受け取る能力を持つが、長い文脈をどの程度うまく利用できるかについては比較的知られていない。我々は、入力コンテキスト中の関連情報を特定する必要がある2つのタスク、すなわち複数文書の質問応答とキーバリュー検索における言語モデルの性能を分析する。その結果、関連する情報の位置を変えると性能が著しく低下することがわかり、現在の言語モデルが長い入力文脈の情報をロバストに利用できていないことが示された。特に、関連する情報が入力コンテキストの先頭または末尾にある場合に性能が最も高くなることが多く、長いコンテキストの途中で関連する情報にアクセスしなければならない場合には、明示的に長いコンテキストのモデルであっても性能が著しく低下することが観察された。我々の分析は、言語モデルがどのように入力コンテキストを使用するかについての理解を深め、将来のロングコンテキスト言語モデルのための新しい評価プロトコルを提供する。

コメントを残す