Googleは、本日のAIに焦点を当てた他の発表に加えて、新しい「マルチサーチ」機能が、Googleレンズがすでに利用可能な場所であればどこでも使用可能になったことを発表した。この機能は、テキストと画像を同時に使って検索するもので、スマートフォンの機能をより活用する新たな検索方法として、昨年4月に初めて導入された。このバリエーションとして、地元企業に検索対象を絞る「multisearch near me」も、Web用のマルチサーチやAndroidユーザー向けの新しいLens機能と同様に、今後数カ月の間にグローバルに利用可能になる予定だ。

マルチサーチはMultitask Unified Model(MUM)と呼ばれるAI技術によって実現されており、テキスト、写真、ビデオなどさまざまな形式の情報を理解し、トピック、コンセプト、アイデアの間に洞察やつながりを導き出すことができる。Googleは、MUMをGoogle Lensのビジュアル検索機能で活用し、ユーザーがビジュアル検索のクエリにテキストを追加できるようにした。

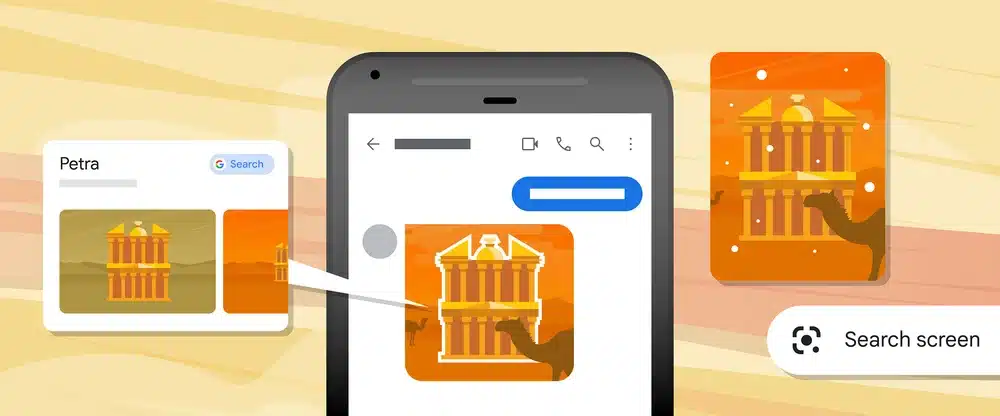

例えば、友人が、パリを探索するビデオをメッセージで送ってきたとする。その背景に写っているランドマークについてもっと知りたい場合は、Android携帯の電源ボタンかホームボタンを長押しして(Google Assistantが起動します)、”検索”をタップすればいい。Lensはそれをリュクサンブール宮殿と認識し、クリックして詳細を確認することができる。

また、ユーザーは例えばGoogle Lensで気に入った家具を検索し、その製品のカラーバリエーションを検索するようなことや、Google Lensでで気に入ったシャツの写真を検索し、同じ柄で別の種類の衣服、例えばスカートや靴下はどこにあるか尋ねることができる。あるいは、自転車の壊れた部品にスマートフォンを向けて、Google検索に「修理方法」などのクエリを入力することもできる。このように、文字と画像を組み合わせることで、Googleはこれまで処理できなかった検索クエリや、文字だけでは入力が困難だった検索クエリを処理し、理解できるようになるかも知れない。

この技術は、ショッピングの検索で最も役に立つ。例えば、気に入った服があっても、色やスタイルが違っていたりする。また、ダイニングセットなどの家具を撮影して、それに合うコーヒーテーブルなどを探すことも出来る。マルチサーチでは、ユーザーはブランド、色、視覚的な属性で検索結果を絞り込むこともできるとGoogleは述べている。

この機能は昨年10月に米国のユーザーに提供され、その後12月にインドに拡大された。本日現在、Googleによると、マルチサーチはモバイルで世界中のすべてのユーザーが、Lensが利用可能なすべての言語と国で利用可能であるという。

またGoogleは、近々登場するGoogle Lens機能を予告し、AndroidユーザーがスマートフォンのアプリやWebサイトにとどまったまま、写真やビデオで見たものを検索できるようになると予告した。

Source

- Google The Keyword: From images to videos, how AI is helping you search visually

コメントを残す