GoogleのAI研究部門であるDeepMindは、33の学術研究所と提携し、汎用ロボット学習のための新しいリソース・セットを立ち上げた。

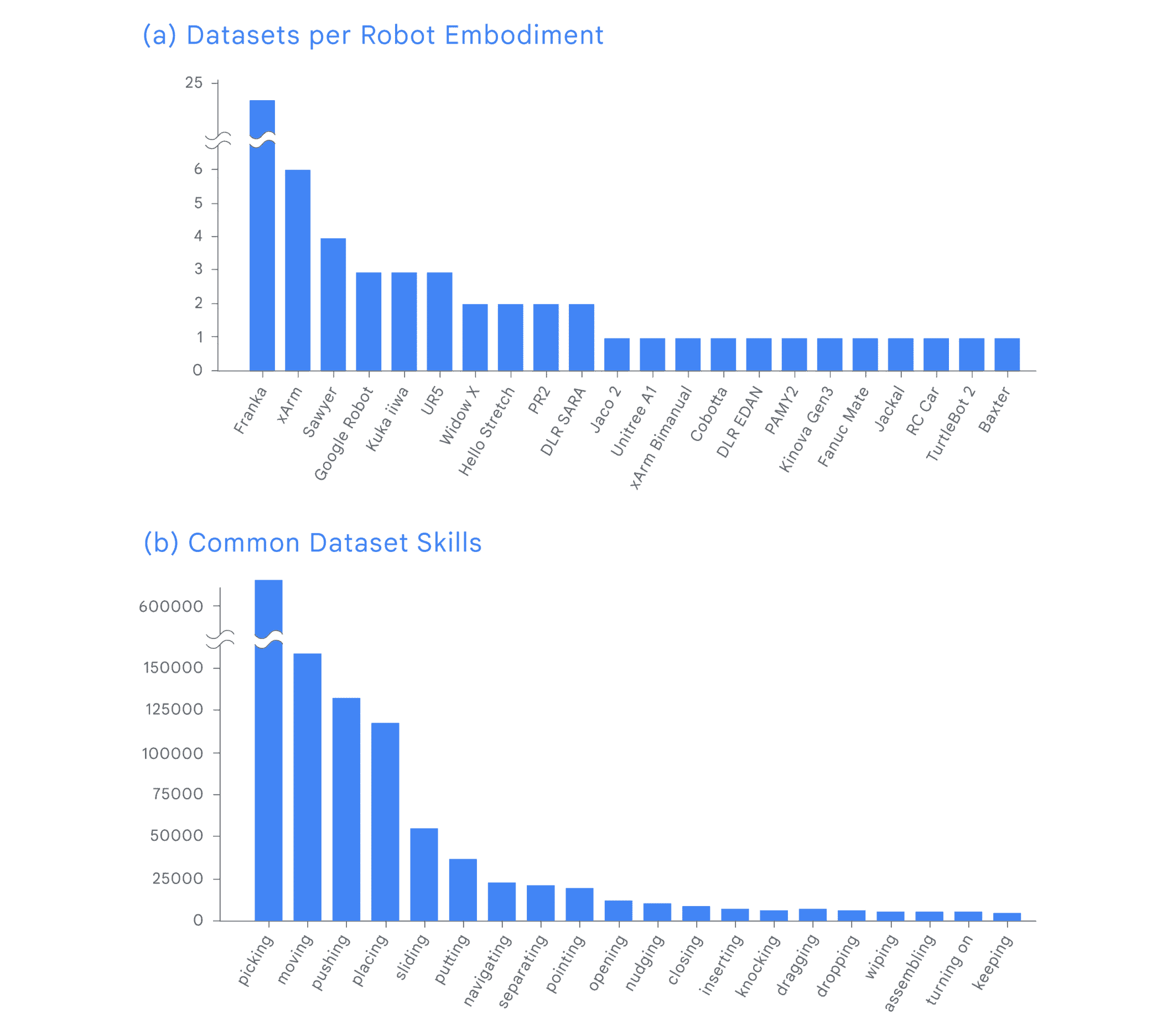

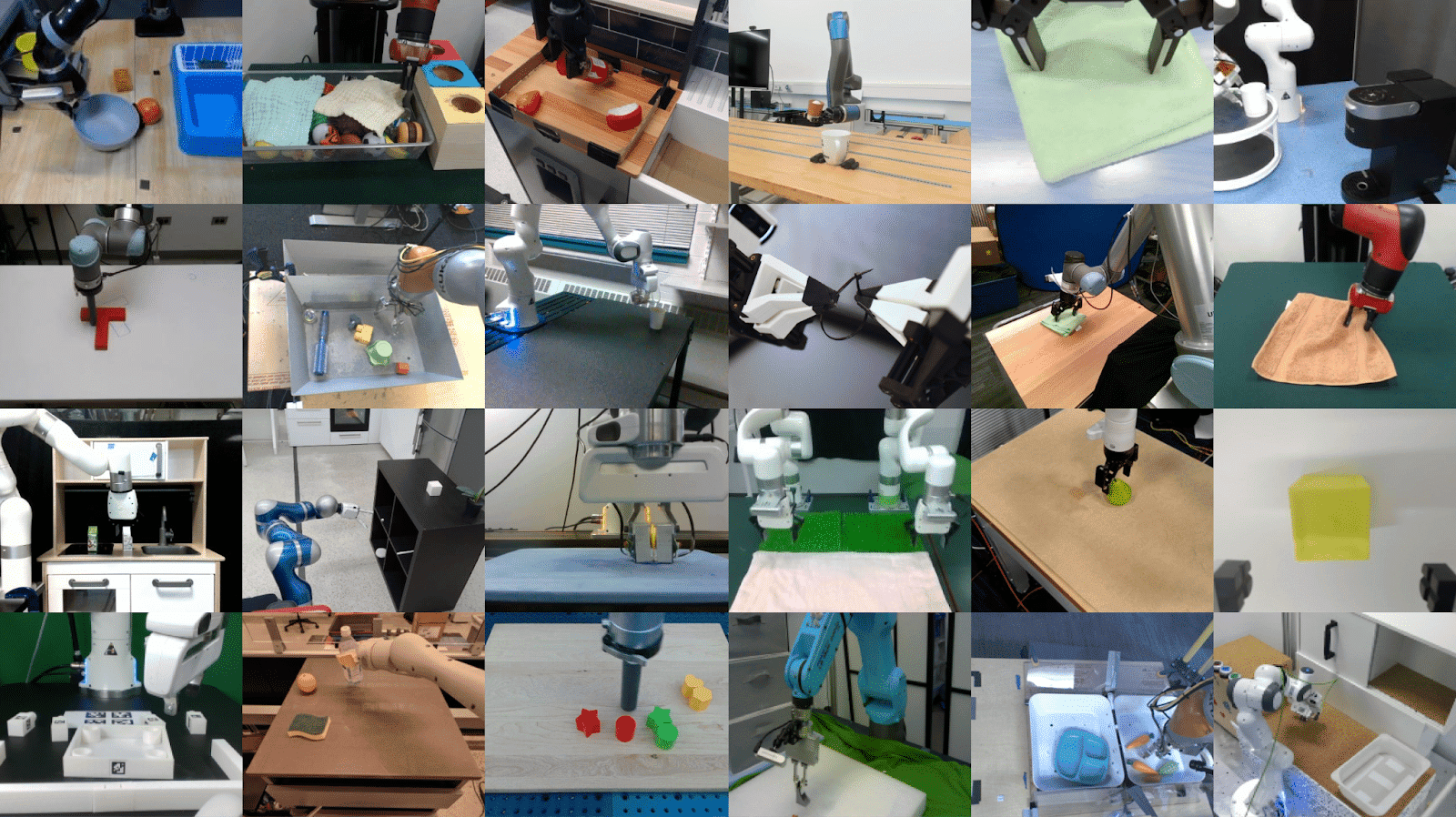

「Open X-Embodiment」と名付けられたデータセットは、22種類のロボットから収集した情報を含む大規模なものだ。これらのロボットは、100万回以上のエピソードの間、527の異なることを行い、15万以上のタスクを完了した。特筆すべきは、このデータセットがこの種のものとしては最大であり、多くの異なるタイプのロボットを理解し制御できるコンピューター・プログラム、つまり一般化されたモデルを作るための一歩であるということだ。

ロボット工学は特にデータの問題を扱っているため、このデータセットは時代の要請である。一方では、大規模で多様なデータセットは、それぞれの専門分野で狭いデータセットを持つモデルよりも優れている。一方で、膨大なデータセットを構築するのは、面倒なリソースと時間のかかる手順である。さらに、その品質と関連性を維持することは困難である。

NVIDIA AIのリサーチ・サイエンティストであるJim Fan氏は、「今日は、ロボット工学にとってのImageNetの瞬間かもしれない」とXにポストしている。彼はさらに、11年前にImageNetがディープラーニング革命を起こし、最終的に最初のGPTと拡散モデルにつながったと指摘した。「2023年はついにロボティクスがスケールアップする年だと思います」と彼は付け加えた。

研究者たちは、最新のOpen X-Embodimentデータセットを使って、2つの新しいジェネラリスト・モデルを訓練した。ひとつはRT-1-Xと呼ばれるもので、ロボットを制御するために設計されたトランスフォーマーモデルである。このモデルは、ドアを開けるなどのタスクを、そのためだけに作られたモデルよりも50%高い平均成功率で実行する。

もう1つのRT-2-Xは、視覚言語行動モデルで、見聞きしたことを理解し、インターネットからの情報もトレーニングに利用する。これらのプログラムは、基本的なアーキテクチャは同じでも、前身のRT-1やRT-2よりも優れている。重要なのは、以前のモデルはより狭いデータセットで訓練されていたことだ。

ロボットはまた、これまで一度も訓練されたことのないタスクの実行を学習した。これらの創発的なスキルは、他のタイプのロボットから取り込まれた経験の範囲にエンコードされた知識によって学習された。実験中、DeepMindチームは、より優れた空間理解を必要とするタスクに関して、これが当てはまることを発見した。

同チームはデータセットと学習済みモデルの両方をオープンソース化し、他の研究者がこの研究を継続できるようにしている。

論文

参考文献

- Google DeepMind: Scaling up learning across many different robot types

研究の要旨

多様なデータセットで訓練された大規模で大容量のモデルは、下流のアプリケーションに効率的に取り組む上で顕著な成功を示している。NLPからコンピュータビジョンに至る領域において、これは事前学習済みモデルの統合につながり、一般的な事前学習済みバックボーンは多くのアプリケーションの出発点として機能している。このような統合はロボット工学でも実現できるのだろうか?従来、ロボットの学習手法は、アプリケーションごと、ロボットごと、さらには環境ごとに個別のモデルを訓練していた。その代わりに、新しいロボット、タスク、環境に効率的に適応できる「汎用的な」Xロボットポリシーを訓練することはできるだろうか?本論文では、ロボット操作の文脈でこの可能性を探ることを可能にする標準化されたデータ形式とモデルのデータセットを、効果的なXロボットポリシーの例を示す実験結果とともに提供する。我々は、21の研究機関の協力により収集された22の異なるロボットから、527のスキル(160266タスク)を示すデータセットを組み立てる。我々は、RT-Xと呼ぶ、このデータに基づいて訓練された大容量モデルが、肯定的な転移を示し、他のプラットフォームからの経験を活用することによって、複数のロボットの能力を向上させることを示す。

Sources

- Google DeepMind: Scaling up learning across many different robot types

コメントを残す