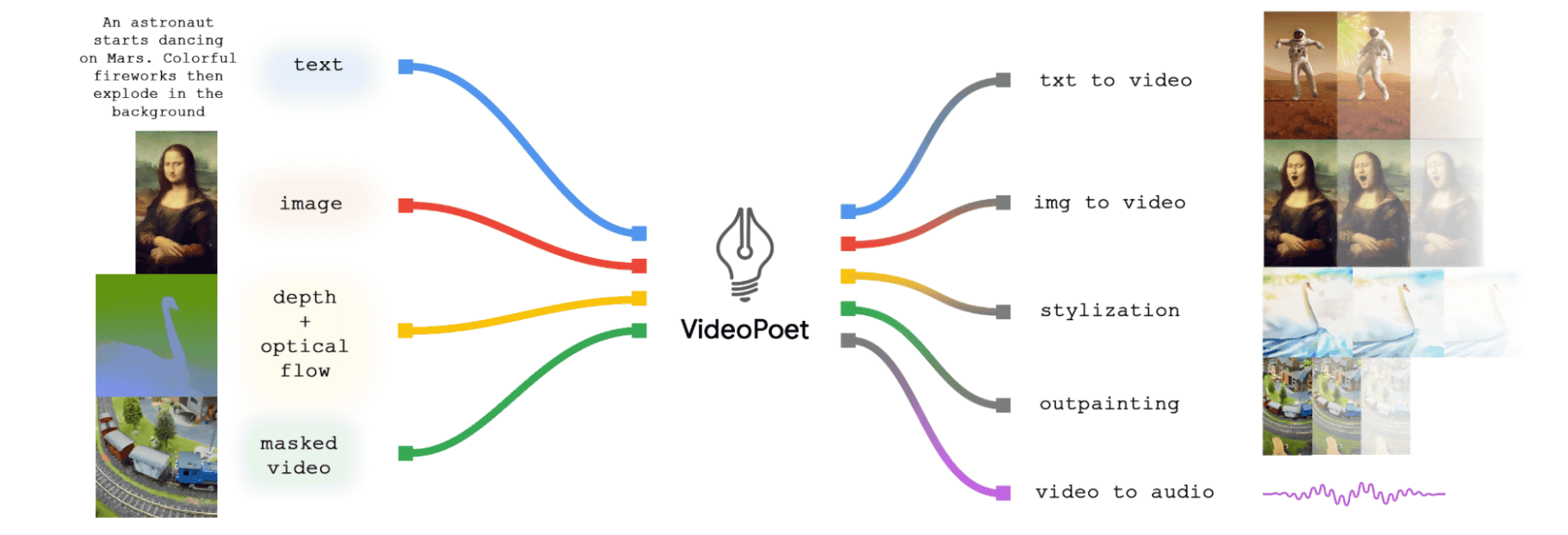

Google、動画生成のための新しい大規模言語モデル(LLM)である「VideoPoet」を発表した。このモデルは、テキストから動画、画像から動画、動画のスタイル化、動画のインペインティングとアウトペインティング、動画から音声への変換など、さまざまなタスクを実行できるように設計されている。

VideoPoetは、映像の中で首尾一貫した大きな動きを作り出すという課題に対処するもので、現在の映像生成技術における限界に挑戦するものだ。

この新しいモデルは、単一のLLMフレームワーク内に複数の動画生成機能を統合することで、既存モデルの分割アプローチとは対照的に差別化を図っている。様々なモダリティを使用し、ビデオと画像にはMAGVIT V2、音声にはSoundStreamといった複数のトークナイザーを用いて学習される。これにより、VideoPoetは、画像のアニメーションから、テキスト入力に基づく動画の編集やスタイリングまで、多様なタスクを実行できる。

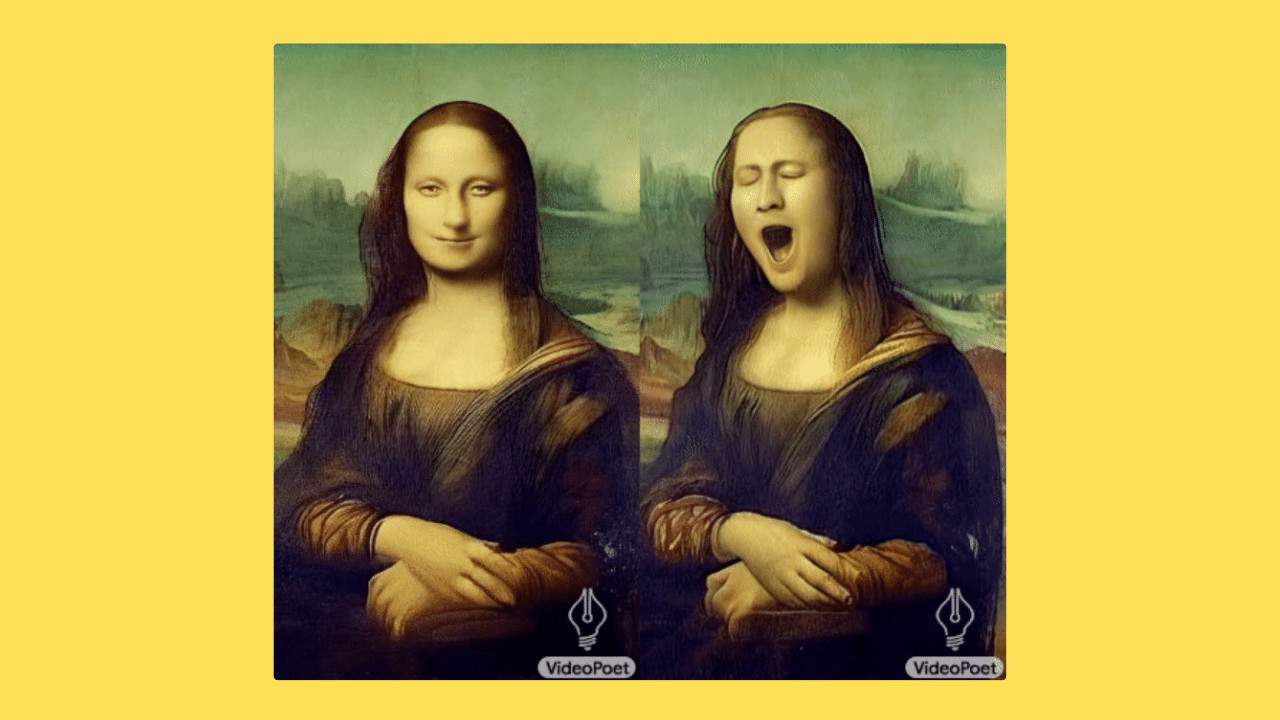

VideoPoetは、既存のビデオの編集にも使用出来る。例えば、このツールを使って、静止画像にアニメーションを追加したり、ビデオのスタイルを変更したりすることが可能だ。このため、VideoPoetは、経験があまりない人でも、ビデオ編集のための強力なツールとなりえる。

VideoPoetが使用できる具体的な作業は以下の通りだ:

- テキストからビデオへ:テキストからビデオへ:テキストの説明からビデオを生成する。

- 画像から動画へ:静止画像をアニメーション化する。

- 動画のスタイル設定:動画にスタイル効果を適用する。

- 動画のインペイントとアウトペイント:動画の欠落部分を埋めたり、動画を元の境界を超えて拡張。

- ビデオからオーディオへ:ビデオクリップからオーディオを生成。

他社との比較

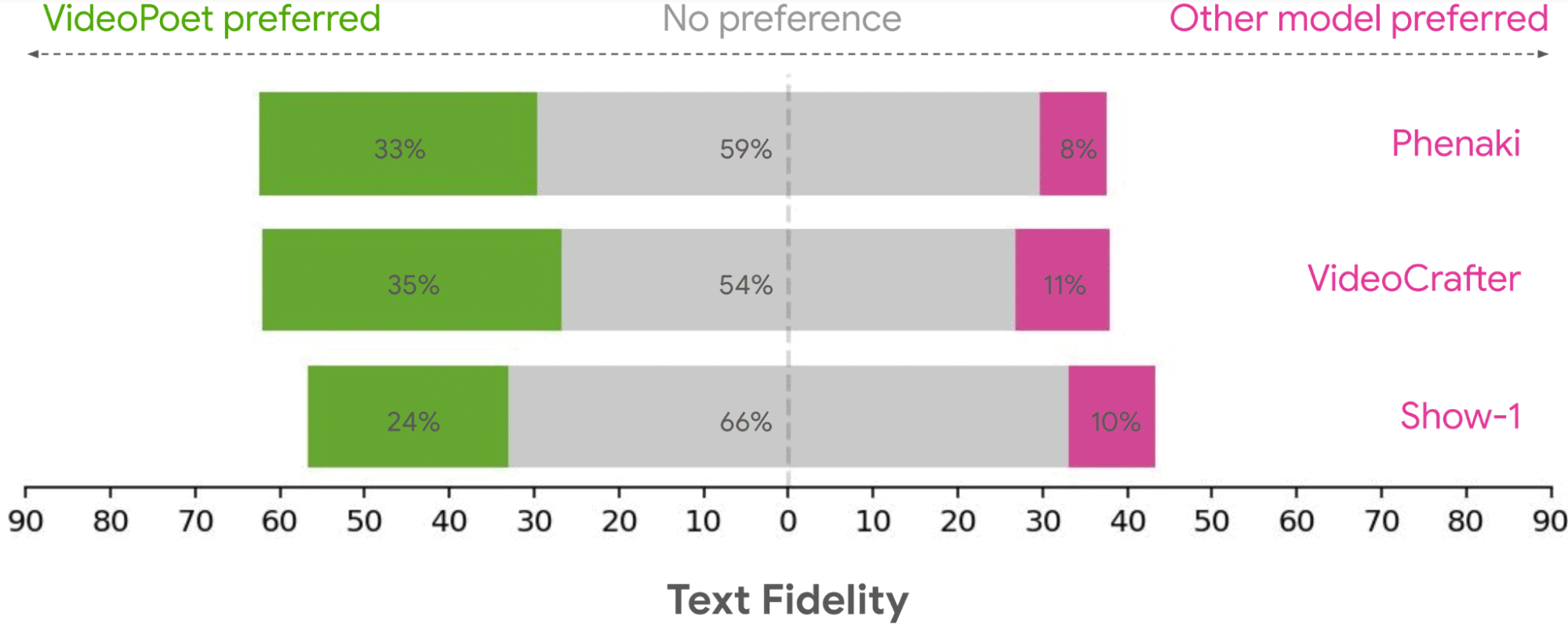

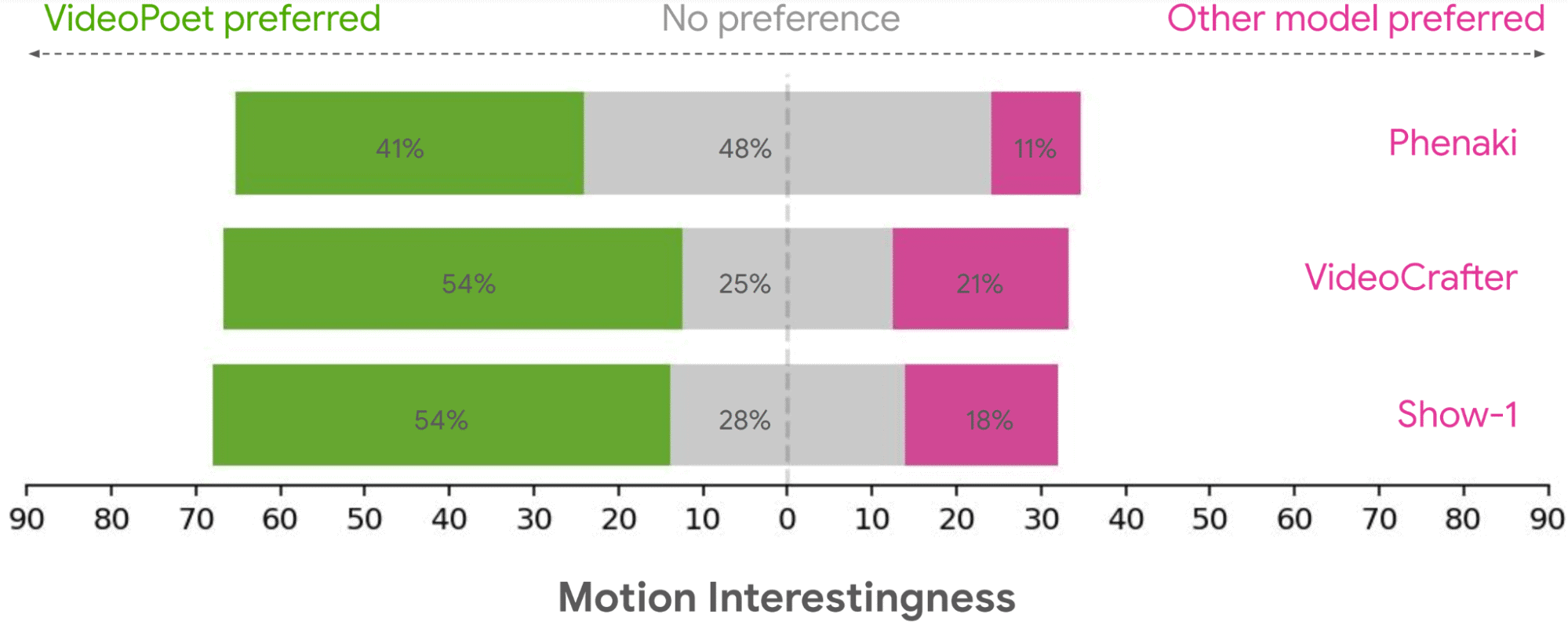

VideoPoetは、テキスト忠実度とモーションの面白さにおいて強化された能力によって、Imagen Video、RunwayML、Stable Video Diffusion、Pika、AlibabaのAnimate Anyoneのような既存のモデルとは一線を画し、AI生成ビデオ技術の進化する状況の中で、他社とは一線を画す。VideoPoetは、より正確にテキストプロンプトに従い、より魅力的なモーションを持つビデオを生成することで、他のモデルを圧倒しているのだ。

比較のポイントは以下の通り:ゼロショット機能、VideoPoetは、他の最新モデルと同様に、1つのテキストプロンプトや画像などの最小限の入力からコンテンツを生成することに優れており、そのコンテンツに関する特別なトレーニングを必要としない。

大きな動きの一貫性に苦労する他のモデルとは異なり、VideoPoetは、テキストプロンプトをビデオに変換する精度の高さを示し、ユーザーエクスペリエンスを向上させている。他のモデルでは、大きな、アーティファクトのないモーションを作成する際にしばしば問題に直面するが、VideoPoetは、よりダイナミックで流動的なビデオを作成し、顕著な改善を示しているのだ。

生成された動画のプロンプトへの忠実度に関しては、調査で過半数のユーザーが「どちらも変わらない」と回答した一方で、動画の面白さという観点では、5割のユーザーが「VideoPoet」に高評価を与えている。

将来の方向性として、「any-to-any」生成をサポートすることができるはずであると、Google Researchは考えており、例えば、テキストからオーディオ、オーディオからビデオ、ビデオキャプションへの拡張を進めるようだ。

Sources

コメントを残す