ChatGPTにおけるNVIDIA GPUの需要増加により、Samsung & SK HynixのHBMを含むDRAMの価格が上昇している。

NVIDIA GPUが、ChatGPTのようなAIツールに最もよく使われており、GPU需要が急増していることは既にお伝えしているが、DRAMメーカーは、NVIDIAのAI GPUを動かすために使用される高帯域幅メモリ、またはHBMソリューションの価格を引き上げ始めている。

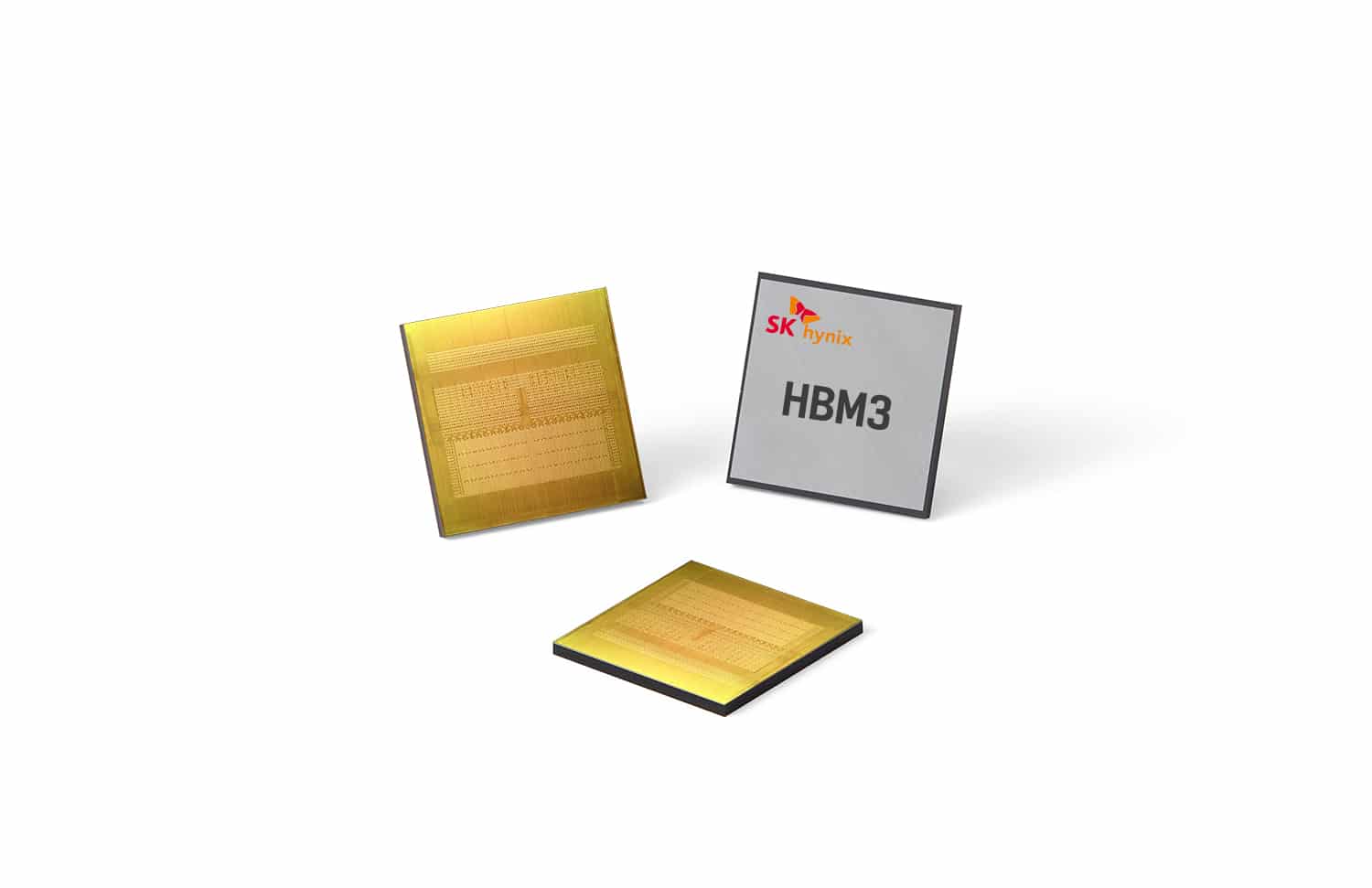

韓国のBusinessKoreaの報道によると、SK hynixやSamsungなどのDRAMメーカーが、HBMを含むメモリソリューションの価格を引き上げていることが明らかになった。NVIDIAがSK hynixに対して、HBM3の生産能力を上げるように要請しているという。しかし、Intelなど他のベンダーも自社の次世代製品にHBM3を統合しようとしており、SK hynixが需要についていけないようだ。そのため、HBMメモリ、特に最新のHBM3ソリューションの価格は5倍程度に高騰している。

人工知能(AI)チャットボット「ChatGPT」の登場は、韓国のメモリー半導体メーカーに新ビジネスを生み出す機会を提供している。ChatGTPは超大型人工知能(AI)を通じて多くのデータを学習し、質問に自然に答えてくれる。ChatGTPのサービスをより良く、より速くするためには、DRAMのデータ処理速度が重要になっている。韓国企業は、これに不可欠な高性能DRAMをすべて生産している。

世界最大のGPU企業であるNvidiaは、SK Hynixに最新製品であるHBM3チップの供給を要請している。世界1位のサーバーCPU企業であるIntelもSK HynixのHBM3を搭載した製品を販売するために努力している。業界関係者は “HBM3の価格は最高性能のDRAMに比べ最大5倍に上昇した “と話した。

BusinessKorea

しかし、上がったのはHBM3だけではない。NVIDIAの前世代GPUであるAmpereやVoltaもAI産業で高い需要があり、これらチップに搭載されているHBM2やHBM2eといった古いHBM規格も需要が急増している。SK hynixは単独でHBM市場の大部分を支配しており、60~70%のシェアを占めている。

最近、アナリストや業界関係者は、ChatGPTの成功はNVIDIAに多くの利益をもたらすと述べている。ChatGPTの作成者であるOpenAIは、現在のサーバーのニーズを満たすために、すでに約25,000個のNVIDIA GPUを使用しており、需要が増加し、さらに競合ソリューションが登場する中、最高のAI機能を提供することで知られているNVIDIAのGPUは、間違いなく人気の選択肢になるだろう。

Source

- Business Korea: Samsung and SK Hynix Enjoy a Rush of Orders for New Memories

- via @harukaze5719

コメントを残す