最近話題のチャットボットAI「ChatGPT」や、人気のテキスト画像生成システム「DALL-E」を開発したOpenAIは、テキストから3Dオブジェクトを生成するAI「Point-E」をリリースした。

これまでにもテキストから3Dオブジェクトを生成するAIモデルとしては、GoogleのDreamFusionがあったが、同システムでは画像を生成するのに何時間も、そして多くのGPUが必要だった。それに比較して、OpenAIのPoint-EはGPU1つを用いて1〜2分で3Dオブジェクトを生成してくれるという。

- 論文

- 参考文献

- GitHub: openai/point-e

- TechCrunch: OpenAI releases Point-E, an AI that generates 3D models

3Dモデリングは、様々な産業や用途で利用されている。現代の映画大作のCGI効果、ビデオゲーム、VRやAR、NASAの月のクレーターマッピング・ミッション、Googleの遺産保存プロジェクト、MetaのMetaverseのビジョンは、すべて3Dモデリング機能にかかっている。しかし、NVIDIAがオブジェクト生成の自動化に取り組み、Epic GameのRealityCaptureモバイルアプリでは、iOS携帯があれば誰でも現実世界のオブジェクトを3D画像としてスキャンできるが、フォトリアルな3D画像の作成は依然としてリソースと時間のかかるプロセスだ。

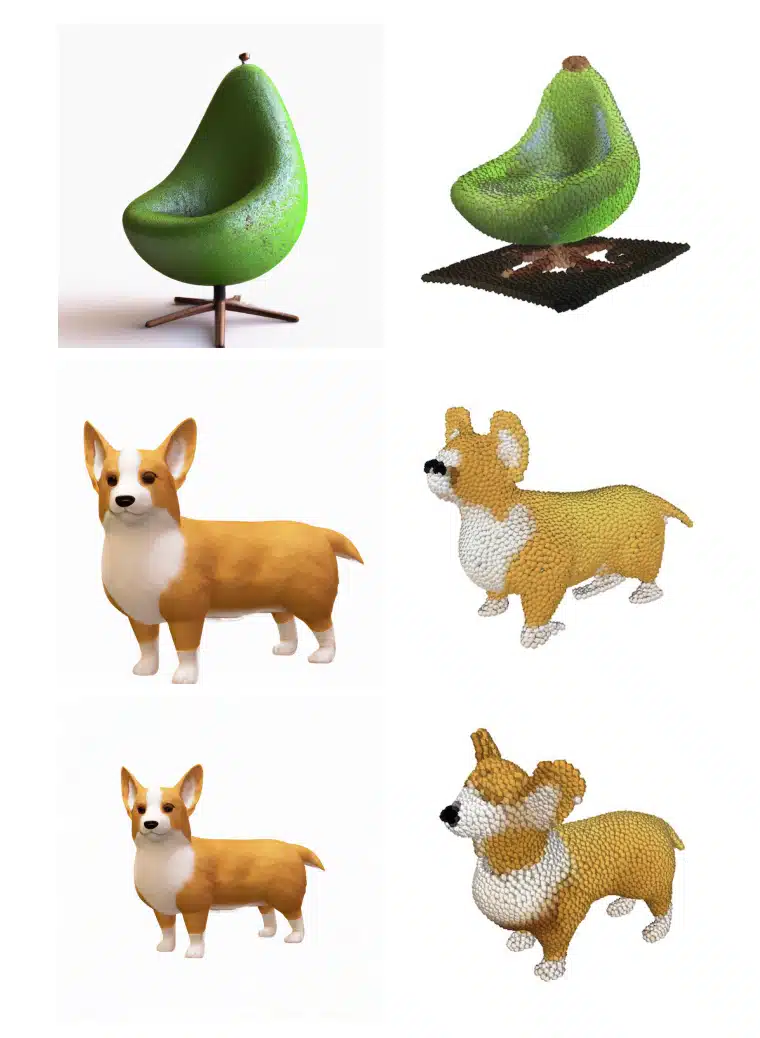

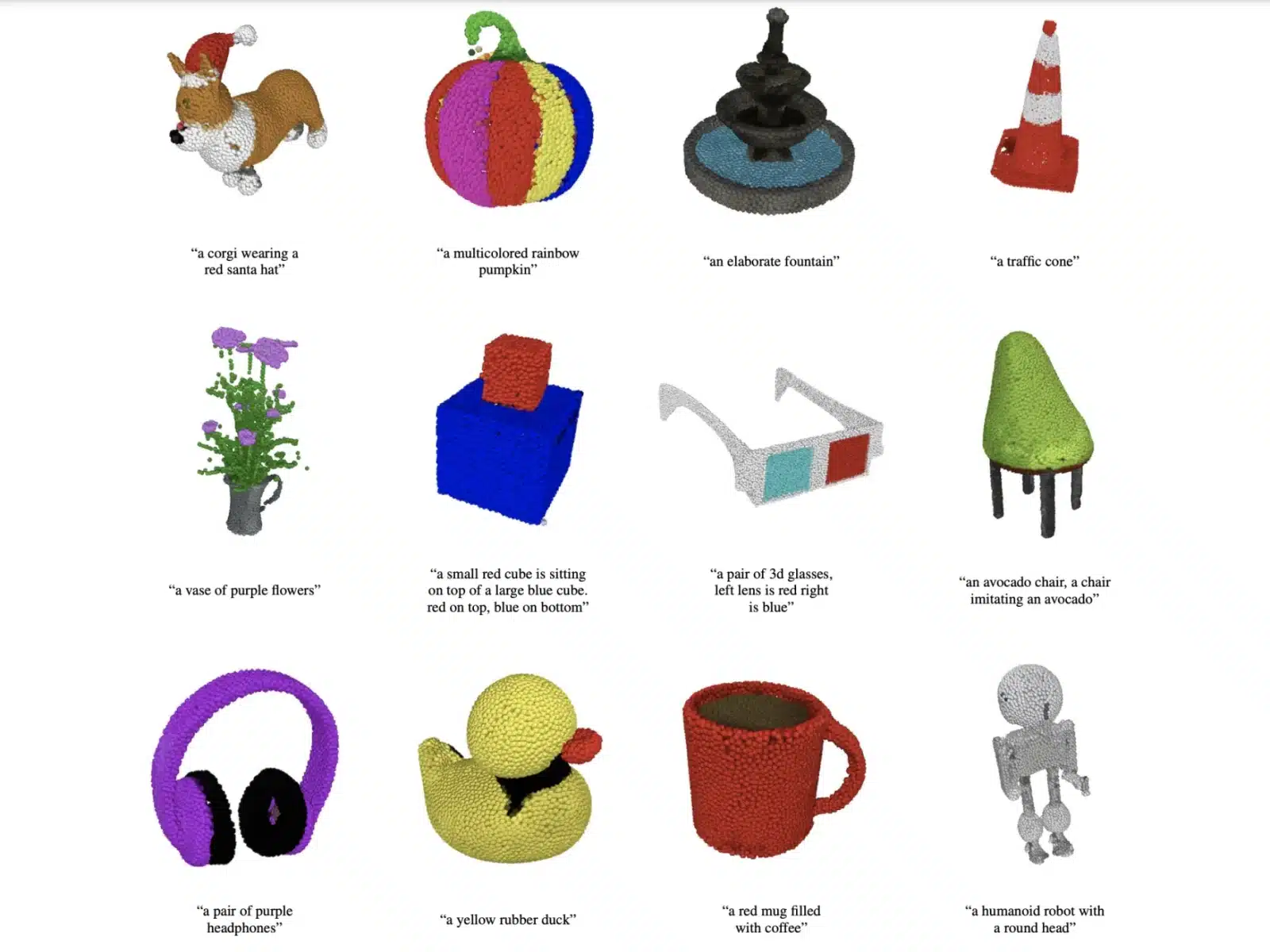

Point-Eは、従来の意味での3Dオブジェクトを作成するものではない。Point-Eは、点群、つまり3D形状を表現する空間上のデータ点の離散的な集合を生成する。(Point-Eの「E」は「Efficiency(効率)」の略で、従来の3Dオブジェクト生成手法よりも高速であることを表している)。点群データは計算機的に合成しやすいのだが、物体の細かい形状やテクスチャーを捉えることができないのが、現在のPoint-Eの大きな欠点だ。

この制限を回避するため、Point-Eでは、点群からメッシュに変換するためのAIシステムを追加で導入した。(メッシュとは、オブジェクトを定義する頂点、辺、面の集まりで、3Dモデリングやデザインによく使われるものだ)。しかし、このモデルでは、物体の特定の部分を見逃すことがあり、その結果、ブロック状や歪んだ形状になることがあると論文で指摘している。

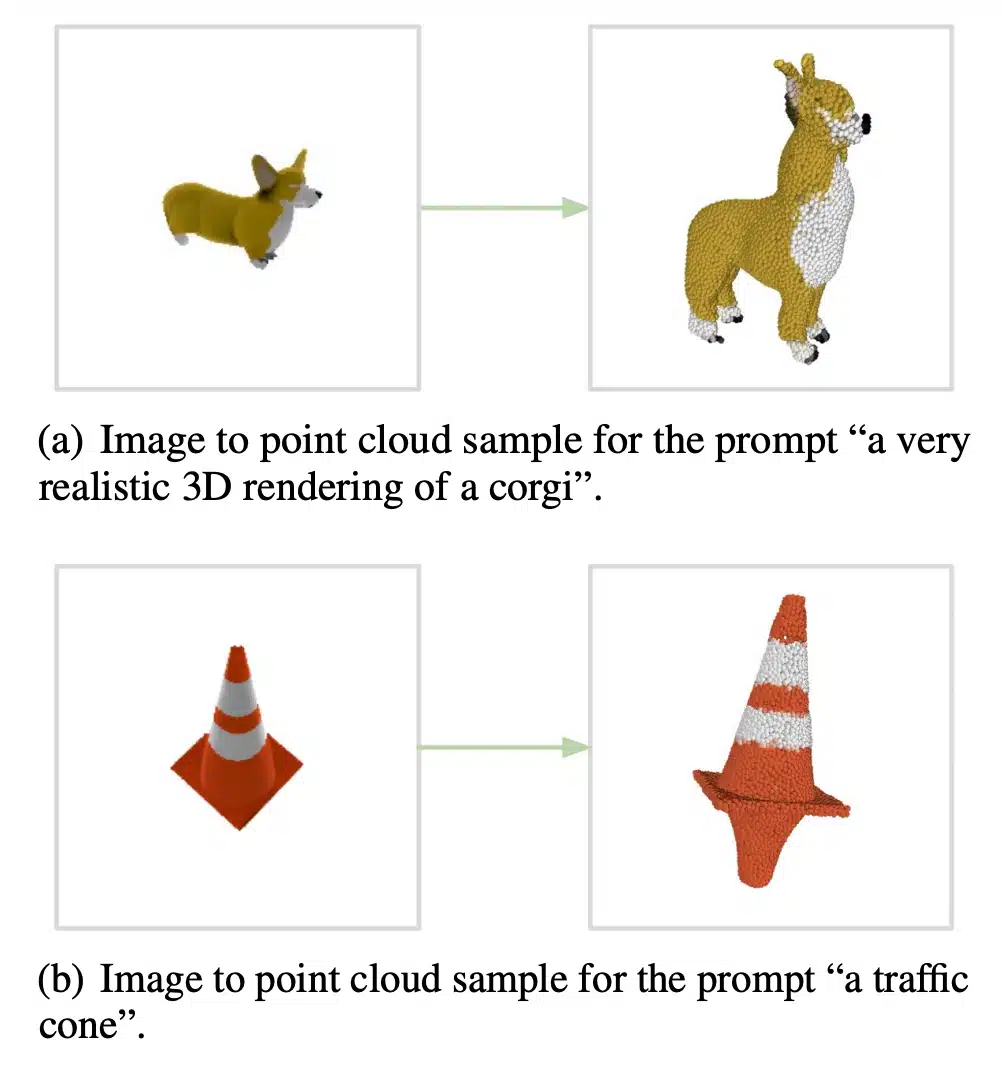

例えば、「洋梨のような椅子」と入力すると、Point-Eはまず洋梨のような椅子の合成ビュー3Dレンダリングを生成する。次に、生成された画像を一連の拡散モデルに通して、最初の画像の3D、RGB点群(最初は粗い1,024点の点群モデル、次に細かい4,096点の点群モデル)を作成する。「実際には、画像にテキストの関連情報が含まれていると仮定し、テキストに対して点群の条件を明示的に与えることはしない」と研究チームは指摘する。

「(テキストと画像の)ペアの大規模なコーパスを活用することで、多様で複雑なプロンプトに従うことができる一方、我々の画像-3Dモデルは、(画像と3Dの)ペアの小さなデータセットで訓練されています。テキストプロンプトから3Dオブジェクトを生成するには、まず、テキスト-画像モデルを使用して画像をサンプリングし、次に、サンプリングされた画像を条件として3Dオブジェクトをサンプリングします。これらのステップは両方とも数秒で実行でき、高価な最適化処理を必要としません。」と、Alex Nichol率いるOpenAI研究チームは、先週発表した論文の中で述べている。

これらの拡散モデルは、それぞれ「数百万」の3Dモデルで学習され、すべて標準的なフォーマットに変換された。「我々の方法は、この評価において、最新の技術よりも悪い結果となりましたが、ほんのわずかな時間でサンプルを作成することができました。」と、研究チームは認めている。

OpenAIはプロジェクトのオープンソースコードをGitHubに掲載しているので、興味があるのならば試すことも可能だ。

研究の要旨

テキスト条件付き3Dオブジェクト生成に関する最近の研究は有望な結果を示しているが、最先端の手法は通常、1つのサンプルを生成するのに数GPU時間を必要とする。これは、数秒から数分でサンプルを生成する最先端の生成画像モデルとは全く対照的である。本論文では、3Dオブジェクト生成のための代替手法を検討し、1つのGPUでわずか1-2分 分程度で生成することができる。本手法は、まずテキストから画像への拡散モデルを用いて1つの合成ビューを生成し、次に生成された画像を条件とする第2の拡散モデルを用いて3D点群を生成する。本手法は、サンプルの品質という点ではまだ最先端には及ばないが、サンプリングの速度は1〜2桁速く、いくつかのユースケースで実用的なトレードオフを提供する。私たちは 学習済みの点群拡散モデル、および評価コードとモデルを https://github.com/openai/point-e で公開する。

コメントを残す